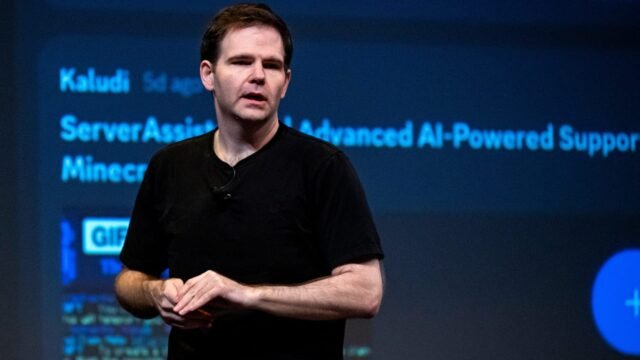

Jonathan Ross, director ejecutivo de Groq Inc., durante la cumbre de Genai en San Francisco, California, EE. UU., El jueves 30 de mayo de 2024.

David Paul | Bloomberg | Getty Photos

La startup de semiconductores de inteligencia synthetic Groq anunció el lunes que ha establecido su primer centro de datos en Europa a medida que aumenta su expansión internacional.

Groq, que está respaldado por los brazos de inversión de Samsung y Ciscodijo que el centro de datos se ubicará en Helsinki, Finlandia y está en asociación con Equinix.

Groq está buscando aprovechar la creciente demanda de servicios de IA en Europa después de otras empresas estadounidenses que también han aumentado la inversión en la región. Los Nordics en explicit son una ubicación common para las instalaciones de datos, ya que la región tiene fácil acceso a energía renovable y climas más fríos. Mes pasado, Nvidia El CEO Jensen Huang estaba en Europa y firmó varios acuerdos de infraestructura, incluidos los centros de datos.

Groq, que está valorado en $ 2.8 mil millones, diseña un chip que la compañía llama una unidad de procesamiento de lenguaje (LPU). Está diseñado para inferencias en lugar de entrenamiento. La inferencia es cuando un modelo de IA pre-entrenado interpreta los datos en vivo para obtener un resultado, al igual que las respuestas producidas por chatbots populares.

Si bien Nvidia tiene un dominio absoluto en los chips requeridos para capacitar a grandes modelos de IA con sus unidades de procesamiento de gráficos (GPU), hay una franja de nuevas empresas que esperan tomar una porción del pastel cuando se trata de inferencias. Sambanova; Ampere, una empresa SoftBank está en proceso de compra; Cerebras y Fractile, todos buscan unirse a la carrera de inferencia de IA.

Hay varias áreas donde Groq quiere destacarse de sus rivales, incluido Nvidia, según el CEO Jonathan Ross.

En una entrevista del lunes con CNBC, Ross dijo que Nvidia Chips usará componentes costosos, como la memoria de alto ancho de banda, que actualmente tienen muy pocos proveedores. Mientras tanto, los LPU de Groq no usan tales chips, y la cadena de suministro de la compañía se basa ampliamente en América del Norte.

“No somos tan limitados de suministro, y eso es importante para la inferencia, que es muy alto volumen, bajo margen”, dijo Ross a “Squawk Field Europe” de CNBC.

“Y la razón por la que somos tan buenos para los accionistas de Nvidia es que estamos felices de tomar ese negocio de alto volumen pero de menor margen y permitir que otros se centren en la capacitación de alto margen”.

Ross también promocionó la capacidad de Groq para implementar su tecnología a velocidad. Dijo que la compañía decidió hace cuatro semanas construir el centro de datos en Helsinki actualmente está descargando sus bastidores de servidores en la ubicación ahora.

“Esperamos servir tráfico a partir de finales de esta semana. Eso se construye rápidamente y, por lo tanto, es una propuesta muy diferente de lo que ves en el resto del mercado”, dijo Ross.

Los políticos europeos han estado impulsando la noción de IA soberana, donde los centros de datos deben ubicarse en la región. Los centros de datos que se encuentran más cerca de los usuarios también ayudan a mejorar la velocidad de los servicios.

World Knowledge Middle Builder Equinix conecta diferentes proveedores de la nube, como Amazon Net Companies y Google Cloud, lo que facilita que las empresas tengan múltiples proveedores. Las LPU de Groq se instalarán dentro del Centro de datos de Equinix, lo que permite a las empresas acceder a las capacidades de inferencia de Groq a través de Equinix.

Groq actualmente tiene centros de datos en los Estados Unidos y Canadá y Arabia Saudita con su tecnología.