Tabla de enlaces

Resumen y 1. Introducción

2 conceptos en datos previos a la proyección y cuantificar la frecuencia

3 Comparación de frecuencia previa a la altura y rendimiento de “disparo cero” y 3.1 configuración experimental

3.2 Resultado: la frecuencia previa a la altura es predictiva del rendimiento de “disparo cero”

4 Probación de estrés La tendencia de escala de rendimiento de la frecuencia conceptual y 4.1 controlar muestras similares en datos previos a la pretruación y aguas abajo

4.2 Prueba de generalización a conceptos puramente sintéticos y distribuciones de datos

5 concepts adicionales de frecuencias conceptuales de pre -proyren

6 Prueba de la cola: ¡Déjalo mover!

7 Trabajo relacionado

8 conclusiones y problemas abiertos, reconocimientos y referencias

Parte I

Apéndice

A. La frecuencia conceptual es predictiva del rendimiento en las estrategias de incorporación

B. La frecuencia conceptual es predictiva del rendimiento a través de las métricas de recuperación

C. La frecuencia conceptual es predictiva del rendimiento para los modelos T2I

D. La frecuencia conceptual es predictiva del rendimiento entre los conceptos solo de los dominios de imagen y texto

E. Detalles experimentales

F. ¿Por qué y cómo usamos RAM ++?

G. Detalles sobre los resultados del grado de desalineación

Modelos H. T2I: evaluación

I. Resultados de clasificación: ¡Déjalo mover!

F ¿Por qué y cómo usamos RAM ++?

Detalamos por qué usamos el modelo RAM ++ [59] en lugar de clipscore [56] o modelos de detección de vocabulario abierto [80]. Además, elaboramos cómo seleccionamos el hiperparámetro umbral utilizado para identificar conceptos en las imágenes.

F.1 ¿Por qué RAM ++ y no clip o detectores de vocabulario abierto?

Proporcionamos algunos ejemplos cualitativos para ilustrar por qué elegimos RAM ++. Nuestras imágenes de entrada a menudo no involucran escenas complejas adecuadas para detectores de objetos, sino muchas clases de grano fino en las que junto con el clip, incluso los potentes detectores de mundo abierto como OWL-V2 [80] tener un bajo rendimiento.

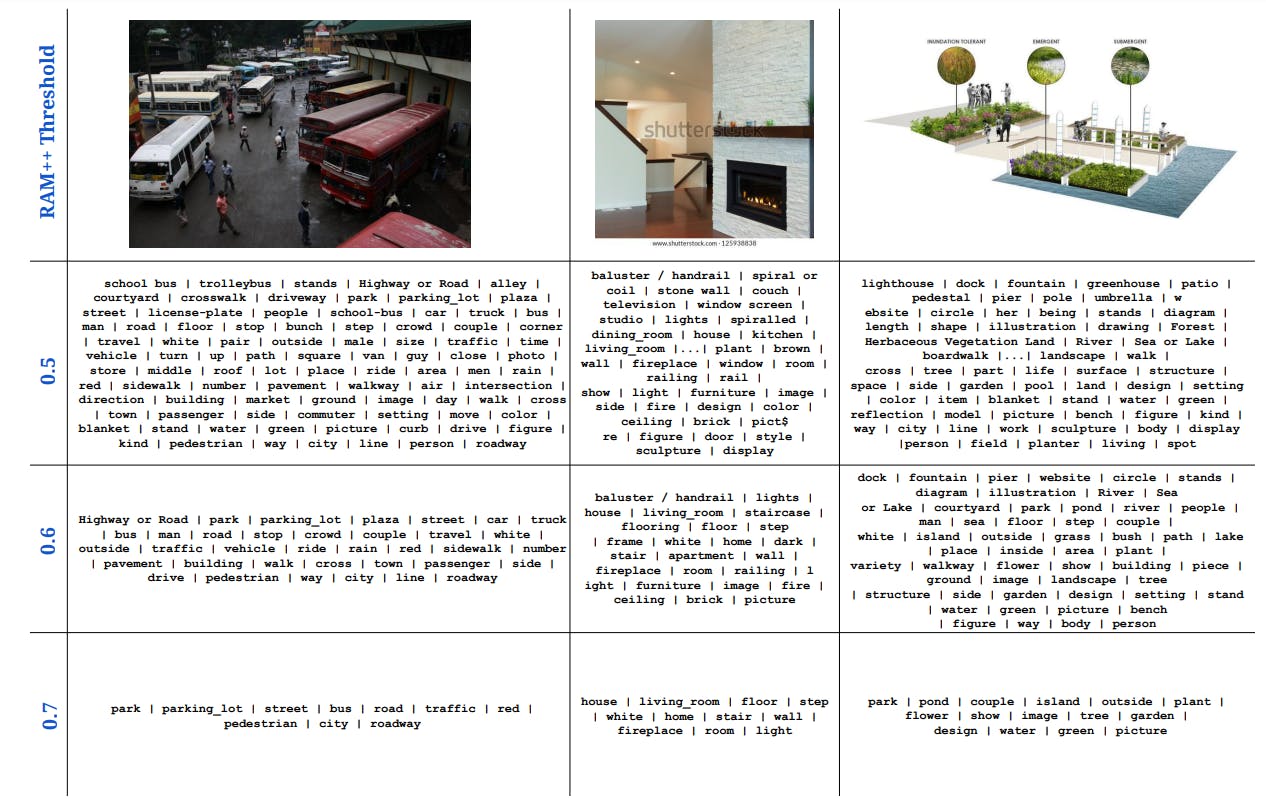

F.2 Cómo: umbral óptimo RAM ++ para calcular las frecuencias conceptuales

Ablacamos la elección del umbral que usamos para asignar conceptos a las imágenes utilizando el modelo RAM ++. Para el conjunto dado de conceptos, RAM ++ proporciona un valor de probabilidad (tomando un sigmoide sobre logits sin procesar) para la existencia de cada concepto en una imagen specific. Para etiquetar una imagen que contiene un concepto specific, tenemos que establecer un umbral que decida este asignación. Probamos más de tres umbrales: {0.5, 0.6, 0.7}, que muestra resultados cuantitativos y cualitativos para todos los umbrales en las Figs. 20 y 21.

Observamos los mejores resultados de estimación de frecuencia utilizando la mayor frecuencia de 0.7. Esto se debe a la alta precisión que ofrece este umbral, lo que nos lleva a contar solo las “imágenes más alineadas” por concepto como golpes. Con umbrales más bajos (0.5, 0.6), observamos que las imágenes más ruidosos que no se alinean bien con el concepto pueden considerarse como golpes, lo que lleva a una precisión degradada y, por lo tanto, una estimación de frecuencia más pobre. Por lo tanto, usamos 0.7 como umbral para todos nuestros resultados principales.

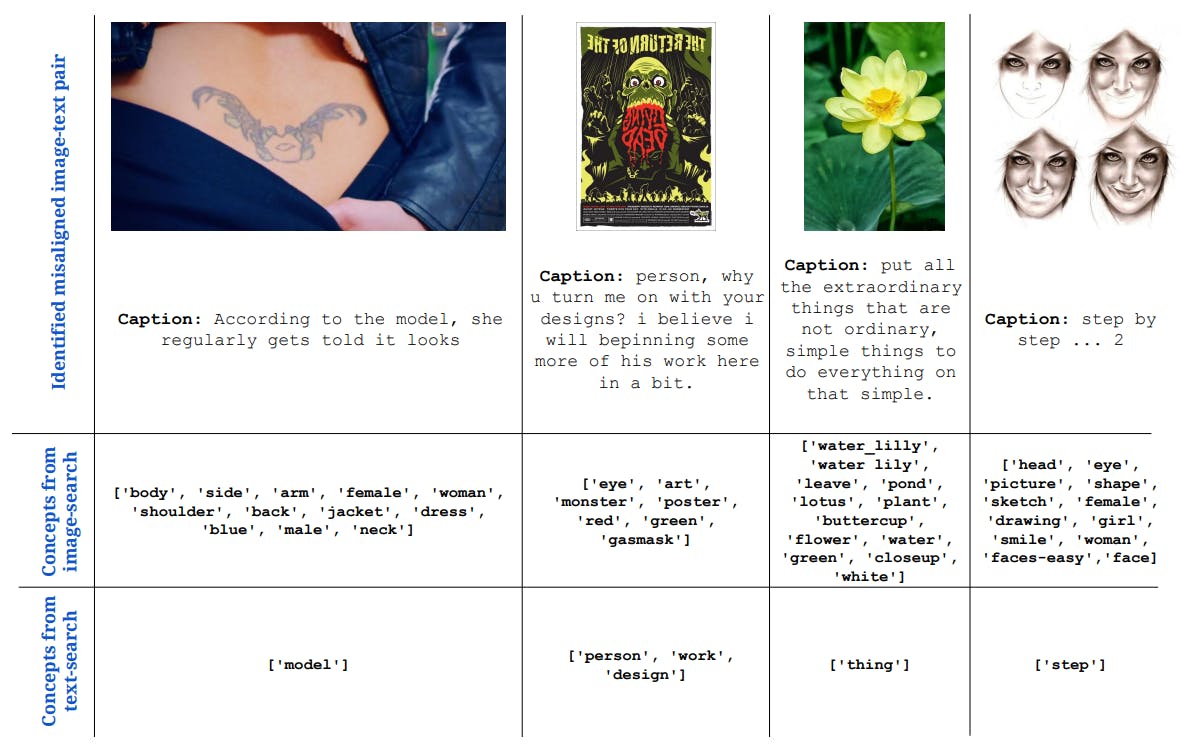

G Detalles sobre resultados de grado de desalineación

En la pestaña. 3 En el documento principal, cuantificamos el grado de desalineación y mostramos que una gran cantidad de pares de texto de imagen en todos los conjuntos de datos de pretrenesa están desalineados. En alg. 1, describimos el método utilizado para cuantificar el Grado de desalineación para cada conjunto de datos de previación. También mostramos algunos ejemplos cualitativos de algunos pares de texto de imagen del conjunto de datos CC-3M que se identifican como desalineados utilizando nuestro análisis.

Autores:

(1) Vishaal Udandarao, Tubingen AI Heart, Universidad de Tubingen, Universidad de Cambridge y contribución igual;

(2) Ameya Prabhu, Tubingen AI Heart, Universidad de Tubingen, Universidad de Oxford, y contribución igual;

(3) Adhiraj Ghosh, Tubingen AI Heart, Universidad de Tubingen;

(4) Yash Sharma, Centro Tubingen AI, Universidad de Tubingen;

(5) Philip HS Torr, Universidad de Oxford;

(6) Adel Bibi, Universidad de Oxford;

(7) Samuel Albanie, Universidad de Cambridge e igual asesoramiento, orden decidida por un volteo de monedas;

(8) Matthias Bethge, Tubingen Ai Heart, Universidad de Tubingen y el mismo asesoramiento, orden decidido por un cambio de moneda.