Autores:

(1) Jiaben Chen, Universidad de Massachusetts Amherst;

(2) Xin Yan, Universidad de Wuhan;

(3) Yihang Chen, Universidad de Wuhan;

(4) Siyuan Cen, Universidad de Massachusetts Amherst;

(5) Qinwei MA, Universidad de Tsinghua;

(6) Haoyu Zhen, Universidad de Shanghai Jiao Tong;

(7) Kaizhi Qian, MIT-IBM Watson AI Lab;

(8) mentir Lu, Dolby Laboratories;

(9) Chuang Gan, Universidad de Massachusetts Amherst.

Tabla de enlaces

Resumen y 1. Introducción

-

Trabajo relacionado

2.1 Texto a la generación vocal

2.2 Generación de texto a movimiento

2.3 Generación de audio a movimiento

-

Conjunto de datos de estrago

3.1 subconjunto de rap-vocal

3.2 subconjunto de movimiento de rap

-

Método

4.1 Formulación de problemas

4.2 MOVIMIENTO TOKENIZER VQ-VAE

4.3 tokenizador de audio vocal2unit

4.4 Modelado basic de autosuficiencia

-

Experimentos

5.1 Configuración experimental

5.2 Análisis de resultados principales y estudio de ablación 5.3

-

Conclusión y referencias

A. Apéndice

Abstracto

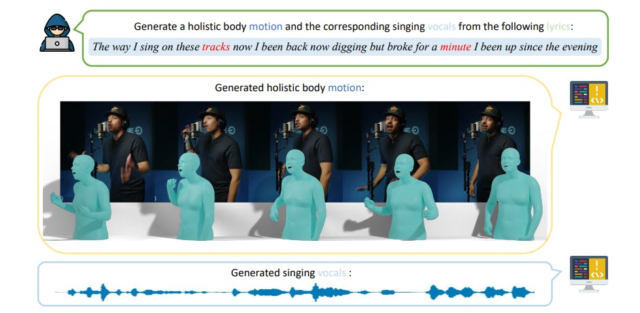

En este trabajo, presentamos una tarea desafiante para generar simultáneamente los movimientos del cuerpo holístico 3D y cantar voces directamente de las entradas de letras textuales, avanzando más allá de los trabajos existentes que generalmente abordan estas dos modalidades de forma aislada. Para facilitar esto, primero recopilamos el conjunto de datos Rapverse, un gran conjunto de datos que contiene voces sincrónicas de rap, letras y mallas del cuerpo holístico 3D de alta calidad. Con el conjunto de datos Rapverse, investigamos en qué medida la escala de transformadores multimodales autorregresivos a través del lenguaje, el audio y el movimiento puede mejorar la generación coherente y realista de voces y movimientos humanos de todo el cuerpo. Para la unificación de la modalidad, se emplea un autoencoder variacional con vectores con vector para codificar secuencias de movimiento de todo el cuerpo en tokens de movimiento discretos, mientras que se aprovecha un modelo vocal a la unidad para obtener tokens de audio cuantificados que preservan contenido, información prosódica e identidad de cantantes. Al realizar conjuntamente el modelado de transformadores en estas tres modalidades de manera unificada, nuestro marco garantiza una combinación perfecta y realista de voces y movimientos humanos. Experimentos extensos demuestran que nuestro marco de generación unificado no solo produce voces de canto coherentes y realistas junto con movimientos humanos directamente de entradas textuales, sino que también rivaliza con el rendimiento de sistemas especializados de generación de modalidad única, estableciendo nuevos puntos de referencia para la generación conjunta de moción vocal. La página del proyecto está disponible para fines de investigación en

1 Introducción

En el panorama en evolución de la generación de contenido multimodal en términos de sonido y movimiento, se han realizado avances significativos en las modalidades individuales, incluido el texto a la música [54, 1, 21]texto a vocal [32]texto a movimiento [13, 69, 4, 23, 34]y audio a movimiento [68, 15, 31] generación. Estos desarrollos han allanado el camino para crear contenido digital más dinámico e interactivo. A pesar de estos avances, los trabajos existentes operan predominantemente en silos, abordando cada modalidad de forma aislada. Sin embargo, existe una fuerte evidencia psicológica de que para los seres humanos, la generación de sonido y movimiento está altamente relacionada y acoplada [28]. Un sistema unificado para la generación conjunta permite una comunicación más expresiva y matizada de emociones, intenciones y contexto, donde la generación de una modalidad podría guiar y ayudar a la otra de una manera coherente y eficiente.

En este artículo, abordamos un problema essential: ¿puede una máquina no solo cantar con profundidad emocional sino también actuar con expresiones y movimientos similares a los humanos? Proponemos una tarea novedosa para generar voces de canto coherentes y movimientos humanos de todo el cuerpo (incluidos los movimientos corporales, los gestos de las manos y las expresiones faciales) simultáneamente, ver Fig. 1. Este esfuerzo tiene un significado práctico en el fomento de interacciones digitales más inmersivas y naturalistas, elevando así las actuaciones virtuales, los juegos interactivos y el realismo de los avatares virtuales.

Una pregunta importante surge naturalmente: ¿qué constituye un buen modelo para la generación unificada de sonido y movimiento? En primer lugar, consideramos las letras textuales como la forma adecuada de entradas para el sistema unificado, ya que el texto proporciona un medio versatile altamente expresivo e interpretable para transmitir información por parte de los seres humanos, y podría servir como un puente entre varias modalidades. Los esfuerzos anteriores exploran los puntajes [32]comandos de acción [69, 4, 23]o señales de audio [68] como entradas, que son inferiores a las entradas textuales en términos de riqueza semántica, expresividad e integración versatile de diferentes modalidades.

En segundo lugar, consideramos que un sistema de generación conjunta que podría producir salidas multimodales simultáneamente es mejor que un sistema en cascada que ejecuta la generación de un solo modal secuencialmente. Un sistema en cascada, que combina un módulo de texto a vocal con un módulo de vocal a movimiento, corre el riesgo de acumular errores en cada etapa de generación. Por ejemplo, una mala interpretación en la fase de texto a vocal puede conducir a una generación de movimiento inexacta, diluyendo así la coherencia prevista de la salida. Además, las arquitecturas en cascada requieren múltiples fases de capacitación e inferencias en diferentes modelos, aumentando sustancialmente las demandas computacionales.

Para construir dicho sistema de generación conjunta, los desafíos principales incluyen: 1) la escasez de conjuntos de datos que proporcionan letras, voces y anotaciones de movimiento de todo el cuerpo en 3D simultáneamente; y 2) la necesidad de una arquitectura unificada capaz de sintetizar coherentemente voces y movimientos del texto. En respuesta a estos desafíos, hemos seleccionado a Rapverse, un conjunto de datos a gran escala con una colección completa de letras, voces de canto y movimientos 3D de cuerpo entero. A pesar de la existencia de conjuntos de datos disponibles para texto a vocal [32, 22, 8, 55]texto a movimiento [44, 35, 13, 30]y audio a movimiento [3, 15, 12, 9, 5, 65]El paisaje carece de un conjunto de datos unificado que encapsula las voces de canto, el movimiento de todo el cuerpo y las letras simultáneamente. En specific, grandes conjuntos de datos de texto a vocal [22, 70] están predominantemente en chino, limitando su aplicabilidad para la investigación del idioma inglés y carecen de datos de movimiento. Y conjuntos de datos de texto a cámara [44, 13, 30] Por lo basic, concéntrese en las descripciones de texto de acciones específicas combinadas con los movimientos correspondientes sin datos de audio, a menudo sin cubrir los movimientos de todo el cuerpo. Además, conjuntos de datos de audio a cámara [32, 33] centrarse principalmente en el habla en lugar de cantar. Una comparación de conjuntos de datos relacionados existentes se demuestra en la tabla. 1. El Bronceado El conjunto de datos se divide en dos partes distintivas para satisfacer una amplia gama de necesidades de investigación: 1) un subconjunto de rap-vocal que contiene una gran cantidad de pares de voces y letras, y 2) un subconjunto de movimiento de rap que abarca voces, letras y movimientos humanos. El subconjunto de rap-vocal contiene 108.44 horas de voz en inglés de alta calidad en el género de rap sin música de fondo. Las letras y voces emparejadas se arrastran de Web de 32 cantantes, con cuidadosa limpieza y postprocesamiento. Por otro lado, el subconjunto de Rap-Movement contiene 26.8 horas de movies de rendimiento de RAP con anotaciones de malla de cuerpo holístico 3D en parámetros SMPL-X [42] Usando la tubería de anotación de Movement-X [30]voces de canto sincrónicas y letras correspondientes.

Con el conjunto de datos Rapverse, exploramos hasta qué punto podemos impulsar simplemente escalar transformadores multimodales autorregresivos con lenguaje, audio y movimiento para una generación coherente y realista de voces y movimientos humanos de todo el cuerpo. Con este fin, unificamos diferentes modalidades como representaciones de tokens. Específicamente, tres vqvaes [63] se utilizan para comprimir secuencias de movimiento de todo el cuerpo en tokens discretos de tres niveles para la cabeza, el cuerpo y la mano, respectivamente. Para la generación vocal, trabajos anteriores [37, 7, 32, 37] Comparta un paradigma común, que produce espectrogramas MEL de señales de audio a partir de características textuales de entrada e información adicional de puntaje musical, siguiendo con un vocoder [40, 62, 67] para reconstruir la fase. Nos inspiramos en el dominio de resíntesis del habla [45]y aprenda una representación discreta auto-supervisada para cuantificar la señal de audio sin procesar en tokens discretos al tiempo que preserva el contenido vocal y la información prosódica. Luego, con todas las entradas en representaciones discretas, aprovechamos un transformador para predecir los códigos discretos de audio y movimiento de manera autorregresiva. Extensos experimentos demuestran que este marco de generación unificado directo no solo produce voces de canto realistas junto con movimientos humanos directamente a partir de entradas textuales, sino que también rivaliza con el rendimiento de los sistemas especializados de generación de modalidad única.

En resumen, este documento hace las siguientes contribuciones:

• Lanzamos Rapverse, un gran conjunto de datos con voces de canto sincrónicas, letras y parámetros Holists SMPL-X de alta calidad.

• Diseñamos un marco unificado easy pero efectivo para la generación conjunta de voces de canto y movimientos humanos del texto con un transformador multimodal de manera autorregresiva.

• Para unificar representaciones de diferentes modalidades, empleamos un modelo de vocal a la unidad para obtener tokens de audio cuantificados y utilizar VQVAE compositivos para obtener tokens de movimiento discretos.

• Los resultados experimentales muestran que nuestro marco rivaliza con el rendimiento de los sistemas especializados de generación de modalidad única, estableciendo nuevos puntos de referencia para la generación conjunta de voces y movimiento.