Tabla de enlaces

Resumen y 1. Introducción

-

Trabajo relacionado

2.1 Texto a la generación vocal

2.2 Generación de texto a movimiento

2.3 Generación de audio a movimiento

-

Conjunto de datos de estrago

3.1 subconjunto de rap-vocal

3.2 subconjunto de movimiento de rap

-

Método

4.1 Formulación de problemas

4.2 MOVIMIENTO TOKENIZER VQ-VAE

4.3 tokenizador de audio vocal2unit

4.4 Modelado basic de autosuficiencia

-

Experimentos

5.1 Configuración experimental

5.2 Análisis de resultados principales y estudio de ablación 5.3

-

Conclusión y referencias

A. Apéndice

En esta sección, presentamos a Rapverse, un gran conjunto de datos de movimiento de música rap que contiene voces de canto sincronizadas, letras textuales y movimientos humanos de todo el cuerpo. Una comparación de nuestro conjunto de datos con conjuntos de datos existentes se muestra en la tabla. 1. El conjunto de datos Rapverse se divide en dos subconjuntos para satisfacer una amplia gama de necesidades de investigación: un subconjunto de RAP-Vocal y un subconjunto de movimiento de rap. La tubería de colección basic de Rapverse se muestra en la Fig. 2.

3.1 subconjunto de rap-vocal

El subconjunto de rap-vocal contiene 108.44 horas de voz en inglés de alta calidad en el género de rap con letras emparejadas. Presentaremos cada paso en detalle.

Datos rastreos. En un intento por obtener una gran cantidad de canciones de rap y letras correspondientes de Web, utilizamos SpotDL y Spotipy para coleccionar canciones, letras y metadatos de diferentes cantantes de rap. Para garantizar la calidad del conjunto de datos, realizamos una limpieza en las canciones rastreadas eliminando canciones con letras desalineadas y filtrando canciones que son demasiado largas o demasiado cortas.

Separación de música vocal y de fondo. Dado que las canciones de rastreo se mezclan con voces de rap y música de fondo, y nuestro objetivo es sintetizar voces de canto de datos limpios separados, utilizamos el bírculo [18]la herramienta de separación de origen vocal de origen abierto de última generación para separar y extraer voces vocales de rap y música de fondo acompañante de las canciones recopiladas. Siguiente [53]Normalizamos el volumen de las voces vocales a un nivel de volumen fijo.

Procesamiento de datos vocales. Las letras de Uncooked Grawled de Web están en formatos inconsistentes, realizamos una limpieza de datos en la letra eliminando la meta información (cantante, compositor, nombre de la canción, palabras de puente y símbolos especiales). Para garantizar que las letras estén alineadas con las voces de canto, recopilamos las letras solo con las marcas de tiempo correctas de cada oración, y separamos cada canción en segmentos de alrededor de 10 segundos a 20 segundos para el entrenamiento modelo.

3.2 subconjunto de movimiento de rap

El subconjunto de Rap-Movement contiene 26.8 horas de movies de rendimiento de RAP con anotaciones de malla de cuerpo holístico 3D en parámetros SMPL-X [42]voces de canto sincrónicas y letras correspondientes. Presentamos la tubería de recolección de este subconjunto de la siguiente manera.

Datos rastreos. Nos arrastramos por más de 1000 movies de rendimiento de estudio de YouTube bajo la licencia creativa común. Filtramos movies de baja calidad manualmente para garantizar que los movies cumplan con los siguientes criterios: trabajo de cámara estable, artistas centrados en el marco, una clara visibilidad de todo el cuerpo del artista para capturar datos de movimiento detallados y audio de alta calidad para un análisis vocal preciso.

Procesamiento de datos de audio. Comparable al subconjunto de rap-vocal, aprovechamos el bírculo [19] Aislar las voces de canto de la música acompañante. Dado que los movies de YouTube generalmente carecen de letras emparejadas, empleamos un modelo ASR, Whisper [47]para transcribir con precisión las voces en el texto correspondiente.

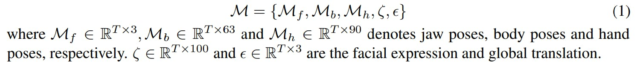

Procesamiento de datos de video. Para garantizar la colección de videoclips de alta calidad para la anotación de movimiento, implementamos un proceso semiautomático para filtrar contenido indeseable, como anuncios, marcos de transición, cambios en las tomas y luces intermitentes. Inicialmente, aplicamos yolo [50] para la detección humana para descartar marcos donde no se detectaron humanos. Posteriormente, utilizamos balsa [60] Para evaluar la magnitud del movimiento, empleando un umbral para eliminar los marcos afectados por la inestabilidad de la cámara. Luego realizamos una curación handbook meticulosa en los clips extraídos, conservando solo los de la más alta calidad. Finalmente, seguimos la tubería del método basado en optimizado Movement-X [30] extraer mallas 3D de cuerpo entero de movies monoculares. Específicamente, adoptamos el SMPL-X [42] Para las representaciones de movimiento, dado un video clip de cuadros t, los estados de pose correspondientes m se representan como:

Autores:

(1) Jiaben Chen, Universidad de Massachusetts Amherst;

(2) Xin Yan, Universidad de Wuhan;

(3) Yihang Chen, Universidad de Wuhan;

(4) Siyuan Cen, Universidad de Massachusetts Amherst;

(5) Qinwei MA, Universidad de Tsinghua;

(6) Haoyu Zhen, Universidad de Shanghai Jiao Tong;

(7) Kaizhi Qian, MIT-IBM Watson AI Lab;

(8) mentir Lu, Dolby Laboratories;

(9) Chuang Gan, Universidad de Massachusetts Amherst.