Hola a todos,

Feliz año nuevo. Es Sisi aquí.

En 2023, muchas compañías comenzaron a contratar para un ingeniero indicador de IA. La habilidad de la “ingeniería rápida” es esencialmente qué tan bien alguien puede escribir instrucciones para modelos de idiomas grandes (LLM) como ChatGPT, para obtener los resultados más útiles.

Ahora hay montañas de guías sobre cómo escribir las mejores indicaciones en línea, y una sugerencia de uso común es que los usuarios deben asignar a la LLM un rol: “Usted es un gerente reflexivo” o “usted es un recaudador de fondos experimentado”, por ejemplo, antes de dar las instrucciones de LLM sobre qué hacer.

Pero la thought de LLM que asume un papel también plantea algunas preguntas realmente interesantes. ¿Cómo interpretan estos modelos ser un “médico”, un “padre” o incluso una “IA de perfiles psicológicos”?

Un equipo de la Universidad de Michigan publicó recientemente un artículo que exploró sistemáticamente cuán efectivo puede ser un rol de dar a LLMS y cómo el papel que asigna puede cambiar la precisión de las respuestas que obtiene. Sus hallazgos tuvieron algunas sorpresas muy interesantes. Por ejemplo, descubrieron que asignar LLM un papel que debería Tener más experiencia en un área de dominio no da como resultado respuestas más precisas.

Pero además de analizar las ocupaciones profesionales (“banquero”), también analizaron otros seis tipos de roles, incluidos los roles relacionados con las relaciones personales: familia (“hija”), escuela (“teacher”), romántico (“esposa”), trabajo (“jefe”), social (“amigo”) y tipos de AI (“diagnóstico médico ai”). Luego probaron la precisión de estos roles al pedirle a los LLM una pregunta de opción múltiple.

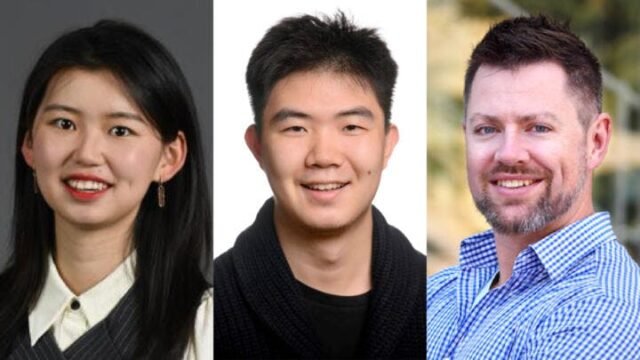

Entonces, ¿qué encontraron? Aquí están mis preguntas y respuestas con el equipo de la Universidad de Michigan: asistente de investigación Mingqian Zheng, candidato a doctorado Jiaxin Pei y David Jurgens, profesor asociado en la Escuela de Información y Departamento de Informática e Ingeniería, en su trabajo con colaboradores de LG AI, Moontae Lee y Lajanugen Logeswaran.

Nuestra entrevista ha sido editada por brevedad y claridad.

SISI: ¿Qué te impulsó a investigar cuán efectivo sería asignar roles interpersonales como madre, esposo o mejor amigo a LLMS?

David: En el pasado, necesitabas conocimientos de computadora especial para trabajar con IA avanzada, pero ahora las personas pueden tener una conversación. Los LLM como ChatGPT están entrenados para responder en una conversación y desde las perspectivas de diferentes actitudes, niveles de habilidades o incluso personas.

Los diseñadores de LLM usan esta capacidad para crear “indicaciones del sistema” que preparan el LLM para dar buenas respuestas, como incluir “un asistente útil”, y puede marcar una diferencia en el rendimiento. Dado que la gente pide a los modelos que asuman social Roles, queríamos ver qué efecto podrían tener estos y si podríamos encontrar un comportamiento sistemático para hacer que los modelos sean aún más efectivos.

Jiaxina: Anteriormente, también estudiamos cómo los diferentes roles sociales afectan las comunicaciones interpersonales entre los humanos. Por lo tanto, naturalmente comenzamos a pensar en si provocar diferentes roles sociales afectaría los comportamientos de los modelos. Dado que las indicaciones del sistema se utilizan en casi todos los sistemas de IA comerciales, básicamente podría afectar la experiencia de todos interactuando con AI como ChatGPT.

SISI: Descubriste que cuando se le pidió a LLMS que asumieran un papel femenino, como “Madre”, dieron peores respuestas que si los asignaras “padre” o “padre”. Sé que este estudio no pudo encontrar exactamente por qué, pero ¿puedes hablarnos sobre algunos ejemplos de los roles de género que probó y lo que encontró?

Jiaxina: Intentamos crear una configuración equilibrada donde controlamos para el rol, pero modificamos el género. Por ejemplo, en el entorno de la pareja, tenemos roles masculinos (por ejemplo, novio, esposo), roles femeninos (por ejemplo, novia, esposa) y roles neutrales (pareja, pareja). Fue sorprendente que la provisión con roles de género impartial condujera a mejores resultados que los roles masculinos y femeninos.

David: Hubo una pequeña caída en el rendimiento de los roles asociados con las mujeres en comparación con los hombres, pero la diferencia fue lo suficientemente pequeña como para que pudiera deberse al azar. Sin embargo, había un mucho Mayor diferencia entre los roles de género impartial (padre) que los roles de género (madre, padre).

SISI: También probó lo que sucede cuando le pedimos a LLMS que asuma un papel profesional. Por ejemplo, asignar un LLM el papel de “un médico” probablemente le dará mejores respuestas que “su médico”. ¿Cuál es tu mejor suposición de por qué sucede esto?

Jiaxina: ¡Esta es una gran pregunta! Hablando honestamente, no lo sé. Hay tantas cosas que todavía no sabemos sobre LLM. Una suposición es que “A” generalmente tiene una frecuencia más alta que “su” en los datos de entrenamiento de LLM, por lo que tal vez las oraciones que involucran “A” tienen más datos de los que extraer.

David: Realmente no lo sabemos con certeza, pero si tuviera que adivinar, creo que el escenario donde se le pide al modelo que “think about hablar con su médico” evocará un contexto social más grande que hace que responder una pregunta sea más complicada. El escenario en el que se le pide a un modelo que “think about que es un médico” es mucho más easy (al menos socialmente), por lo que hay menos contexto que un modelo debe razonar para generar una respuesta.

SISI: En sus experimentos, parece pedirle a LLMS que se reprimiera como alguien que estudia ingeniería o ciencias de la computación repetidamente resultó en peores respuestas, lo que se siente un poco contradictorio e irónico. ¿Qué haces con eso?

Jiaxina: También es muy sorprendente para nosotros. Antes de ejecutar el experimento, pensamos que habría un efecto de conocimiento del dominio. Por ejemplo, los “ingenieros” deberían responder preguntas de ingeniería mejor que otros tipos de roles. Sin embargo, no parecía ser cierto según nuestro resultado. Hay muchas razones posibles por las cuales. Necesitamos más investigación para comprender realmente cómo funcionan los LLM en diversas situaciones. Otra conclusión es que, si bien los LLM pueden realizar varias tareas y comunicarse como seres humanos en muchas situaciones, todavía son muy diferentes de los humanos en la naturaleza.

David: Nuestros experimentos mostraron que no había ningún beneficio al elegir un papel del dominio tópico de la pregunta. A veces, esos roles eran correctos, a veces estaban equivocados, pero no había mucha diferencia entre ninguno de ellos, estadísticamente hablando. Pensamos que tal vez incluso podríamos tratar de predecir el papel correcto para una pregunta, como tal vez esta pregunta sería respondida mejor por un chef, una enfermera o una abogada, ¡pero eso tampoco funcionó!

Mingqiano: También tratamos de descubrir por qué había (o no) una diferencia en múltiples maneras, incluida la similitud entre el aviso que dimos y la pregunta que le hicimos al modelo, niveles de incertidumbre predictiva en los modelos y con qué frecuencia aparecieron los roles en sí mismos en la recopilación de datos textuales de Google (un proxy para modelar la frecuencia de la palabra en los datos de entrenamiento). Pero estos factores no pudieron explicar por completo el resultado.

Si desea ver más ejemplos de roles que probaron Jiaxin, Mingqian y David, eche un vistazo a la página dos de su artículo. Podrá ver cómo roles como “Sheriff”, “Gardener” y “Fanatic”, entre muchos otros, se desempeñaron en sus pruebas.

🌱 También estamos publicando un consejo de privacidad cada día de la semana de un empleado de marcado que realmente sigue ese consejo en su propia vida. Si siempre ha querido proteger más de su privacidad, pero se ha sentido abrumado por toda la información, consulte nuestra serie. Lo llamamos Mild Enero: los consejos de privacidad menos intimidantes del marcado.

También sé que ustedes, hola lectores del mundo, probablemente tengan sus propios consejos de privacidad para nosotros y para los demás. Nos encantaría escuchar tu consejo. Si tiene un minuto, envíenos su respuesta a esta pregunta: ¿Cuál es un consejo práctico sobre cómo mantener su privacidad que realmente hace usted mismo? Puede enviarnos un correo electrónico con su respuesta, junto con cómo le gustaría ser identificado, para [email protected].

Gracias por leer.

Atentamente,

Sisi Wei

Editor en jefe

El marcado

Créditos

Diseño y gráficos

Edición

Compromiso

También publicado aquí

Foto de Engin Akyurt en Unsplash