Los modelos de idiomas grandes (LLM) son muy populares en el mundo del software program en estos días. Presentan nuevos artículos, publicaciones de weblog, cursos y modelos de empresas líderes en nuestra industria, como Meta, Huggingface, Microsoft, and so forth., que requiere que sigamos las nuevas tecnologías de cerca.

Hemos decidido escribir algunos artículos breves e informativos para introducir estos temas y mantenerse actualizado sobre la última tecnología. El primer tema que cubriremos será RAG (generación de recuperación aumentada).

Crearemos una serie de artículos sobre el tema que hemos determinado, con tres artículos diferentes que son útiles y se complementan entre sí. En este artículo, comenzamos nuestra serie con la definición y la información básica de los modelos RAG.

Los modelos de idiomas grandes han entrado en todos los aspectos de nuestras vidas. Podríamos decir que han revolucionado el campo. Sin embargo, no son una herramienta tan perfecta como nos gusta llamarlos. También tiene un gran inconveniente: es fiel a su entrenamiento. Sigue siendo fiel a los datos en los que fue entrenado. No pueden desviarse de esto. Un modelo que completó la capacitación en noviembre de 2022 no podrá dominar noticias, leyes, desarrollos tecnológicos, and so forth., que surgió en enero de 2023. Por ejemplo, un modelo de LLM que completó la capacitación y el servicio en el servicio en 2021 no puede responder una pregunta sobre la guerra de Rusia-Ukraine que comenzó el 24 de febrero de 2022.

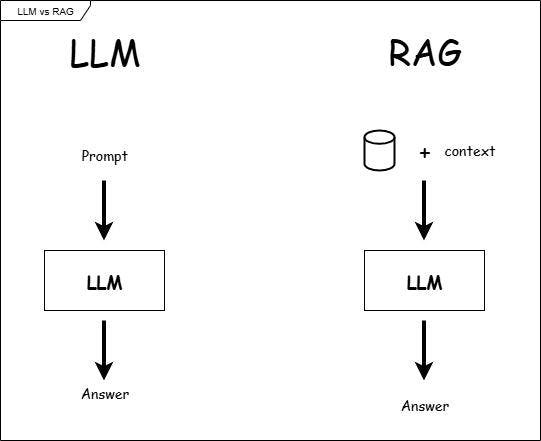

Esto se debe a que su desarrollo se completó antes de esa fecha. Por supuesto, este problema no se dejó sin resolver, y se introdujo un nuevo producto, un nuevo sistema. El sistema RAG (generación de recuperación y generación) surgió para proporcionarle información actualizada cuando la necesite. En el resto de nuestro artículo, echemos un vistazo más de cerca al sistema creado con el modelo LLM y el sistema RAG, uno por uno, para conocerlos.

Acceso a la información en los modelos LLM

El principio de funcionamiento de los modelos de idiomas grandes se basa en los datos enseñados durante la capacitación, en otras palabras, el conocimiento estático. No tienen capacidad para extraer datos externos a través de ningún medio. Para dar un ejemplo, considere a un niño. Si cortamos la comunicación externa de este niño y les enseñamos solo inglés, no podremos escuchar una sola palabra china de ellos.

Esto se debe a que hemos criado a un niño que habla inglés con fluidez, no chino. Al cortar su conexión con el mundo exterior, también hemos restringido su capacidad de aprender de fuentes externas. Al igual que este niño, los modelos LLM también se infunden con conocimientos básicos, pero están cerrados a datos externos.

Otra característica de los modelos LLM es que son cajas negras. Estos modelos no son plenamente conscientes de por qué realizan las operaciones que realizan. Basan sus cálculos únicamente en operaciones matemáticas. Preguntando a cualquier modelo de LLM, “¿Por qué diste esa respuesta?” Probablemente lo estés empujando demasiado fuerte. No responden preguntas a través del razonamiento o la investigación. La palabra clave aquí es “¿Por qué?” También podemos considerarlo un error en los modelos LLM.

Para comprender mejor esta estructura, consideremos un ejemplo del campo de la salud. Cuando un usuario pregunta: “Tengo dolor en la cara y los ojos, y un goteo postnasal persistente. ¿Qué debo hacer?”, El modelo LLM podría responder: “El dolor en mi cara y los ojos, y el goteo postnasal podría ser signos de sinusitis. Por favor, consulte a un médico. La sinusitis aguda se trata con antibióticos. Además de los medicamentos, se puede usar a los espejas nasales como el agua de mar o la sinusitis aguda.

Todo parece regular hasta este punto. Pero si le preguntamos al modelo, “¿Por qué diste esa respuesta?” Después de esta respuesta, las cosas se complican. La razón por la que el modelo proporcionó esta respuesta es porque las palabras “dolor facial” y “goteo nasal” aparecieron con frecuencia junto con la palabra “sinusitis” en los datos de entrenamiento. Estos modelos prefieren almacenar información en su memoria como un patrón estadístico. Las expresiones matemáticas son importantes para los modelos LLM.

Debido a que no prefiere almacenar información en su memoria en función de las fuentes, responde a la pregunta y satisface a la mayoría de las personas al instante, pero cuando las personas con una naturaleza más investigativa preguntan al modelo, “¿Por qué dio esta respuesta?”, El modelo no produce ninguna respuesta explicativa. Creo que ahora tenemos una comprensión suficiente de los modelos LLM. Ahora, podemos discutir el sistema RAG y sus soluciones a estos problemas.

Rag: Combinando LLM con sistemas de recuperación

Los sistemas RAG ofrecen innovaciones en comparación con los sistemas construidos en modelos LLM puros. Una de ellas es que funcionan con información dinámica, no información estática como los modelos LLM. En otras palabras, también escanean fuentes externas sin estar limitados a los datos en los que fueron entrenados. La primera “R” en trapo significa recuperación. El papel del componente de recuperación es realizar operaciones de búsqueda.

El generador es el segundo componente principal, y su papel es generar la respuesta correcta basada en los retornos de recuperación de datos. En este artículo, tocaremos brevemente el principio operativo de Rag: la recuperación escanea la información de fuentes externas y recupere documentos relevantes para la pregunta del usuario al dividirlos en piezas pequeñas llamadas “trozos”.

Vectoriza estos fragmentos y la pregunta del usuario, y luego genera la respuesta más eficiente al examinar el ajuste entre ellos. Esta tarea de generar la respuesta es realizada por “Generación”. Lo discutiremos en detalle en el próximo artículo de esta serie. Estos componentes básicos que forman sistemas de trapo lo convierten en una estructura más fuerte. Peden que se atasquen en información estática como los modelos Pure LLM. Los sistemas RAG ofrecen ventajas significativas, especialmente en muchos campos que requieren información actualizada. Por ejemplo, es posible que desee crear un modelo médico en el campo de la medicina.

Debido a que su modelo servirá a un área very important, no tendrá información obsoleta o incompleta. El mundo médico, al igual que el sector de TI, se está desarrollando todos los días, y se están presentando nuevos estudios. Por lo tanto, se espera que su modelo domine incluso los últimos estudios. De lo contrario, corre el riesgo de poner en peligro la vida humana con un modelo engañoso. En tales casos, los sistemas soportados por RAG eliminan el problema de la información obsoleta al conectarse a bases de datos externas.

La diferencia elementary entre Rag Methods y LLM Fashions es la filosofía central de Rag: “¡No almacene información, acceda a ella cuando lo necesite!” Mientras que los modelos de lenguaje grande puro almacenan información en sus recuerdos y producen respuestas después de recibir capacitación, los sistemas de RAG acceden a la información al buscar y escanear fuera cuando la necesiten, en línea con su filosofía.

Al igual que un humano que busca en Web, esto supera una de las desventajas más significativas de los modelos LLM puros: su relación de memoria. Para ilustrar aún más nuestro punto, podemos comparar estos dos sistemas.

Guión:

Usuario: “¿Cuál es la tasa de inflación de diciembre de 2024 de los Estados Unidos?”

LLM: “Según los datos de diciembre de 2022, fue del 6.5%”. (No es una respuesta actualizada)

TRAPO:

- Recupera datos de diciembre de 2024 de una fuente o base de datos confiable (Banco Mundial, economía comercial, and so forth.).

- LLM usa estos datos y responde: “Según la economía comercial, la inflación en los Estados Unidos para diciembre de 2024 se anuncia como 2.9%”.

Comparemos brevemente lo que hemos discutido hasta ahora y lo presentemos en la tabla a continuación.

|

Características |

LLM (modelo estático) |

Trapo (generación de recuperación y azotación) |

|---|---|---|

|

Información |

Limitado a los datos de capacitación |

Puede extraer información en tiempo actual de fuentes externas |

|

Nivel precise |

Bajo |

Alto |

|

Transparencia |

La fuente de la decisión no se puede revelar (caja negra) |

La fuente se puede citar |

En conclusión, para resumir brevemente, mientras que los modelos LLM se limitan a los datos en los que están capacitados, los sistemas RAG no solo se basan en un modelo LLM específico y tienen conocimientos básicos, sino que también tienen la capacidad de extraer información en tiempo actual de fuentes externas. Esta ventaja asegura que siempre esté actualizado. Esto concluye el primer artículo de nuestra serie. En el próximo artículo, profundizaremos en los aspectos más técnicos. Para los amigos que desean acceder o examinar la práctica de este trabajo, pueden encontrar los enlaces a los repositorios relevantes que creé con Python y bibliotecas relacionadas en mi cuenta de GitHub al ultimate del artículo.

Espero verte en el próximo artículo de la serie.

Metin Yurduseven.

Lectura adicional

“También nos gustaría reconocer la contribución elementary del documento RAG 2020 de Fb AI, que informó significativamente la perspectiva de este artículo”.

Metinyurdev Github

Proyecto de chatbot de trapo multimodelo

Proyecto PDF Rag Chatbot