Tabla de enlaces

-

Introducción

-

Trabajo relacionado

2.1 Diseño de logotipo tipográfico semántico

2.2 Modelo generativo para el diseño computacional

2.3 Herramienta de autoría de diseño gráfico

-

Estudio formativo

3.1 flujo de trabajo basic y desafíos

3.2 Preocupaciones en la participación generativa del modelo

3.3 Espacio de diseño del trabajo de tipografía semántica

-

Consideración de diseño

-

Típica y ideación 5.1

5.2 Selección

5.3 Generación

5.4 Evaluación

5.5 iteración

-

Tutorial de la interfaz y 6.1 etapa previa a la generación

6.2 Etapa de generación

6.3 Etapa posterior a la generación

-

Evaluación y comparación de referencia 7.1

7.2 Estudio de usuarios

7.3 Análisis de resultados

7.4 Limitación

-

Discusión

8.1 Diseño personalizado: colaboración consciente de la intención con AI

8.2 Incorporación del conocimiento de diseño en herramientas de soporte de creatividad

8.3 flujo de trabajo de diseño orientado a usuario de mezcla

-

Conclusión y referencias

5.4 Evaluación

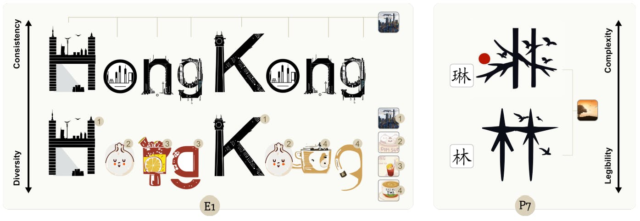

Una vez que se genera el diseño, evaluar el cumplimiento de un diseño con los principios de diseño visible reconocidos es essential para su finalización [9, 37]. Los logotipos tipográficos semánticos requieren un equilibrio entre la legibilidad del tipo de letra y la expresividad de las imágenes, presentando una compensación desafiante. Los diseñadores a menudo confían en los comentarios de los participantes para validar sus diseños. Typdance ofrece una evaluación instantánea basada en datos antes de recopilar las reacciones de los participantes.

Para ayudar a los usuarios a determinar la posición de su trabajo precise en el espectro semántico de tipo, Typedance utiliza un modelo de clip previamente capacitado [39] que proporciona un juicio objetivo respaldado por los datos. Al destilar el conocimiento de un amplio conjunto de datos de 400 millones de pares de texto de imagen de modelo de clip, la tipedura puede cuantificar la similitud entre los tipos de letra y las imágenes en una escala que varía desde [0, 1]con la suma igual a 1. Para mejorar la comprensión intuitiva, Typedance traduce los puntos neutros de 0.5 a 0 y normaliza la distancia entre la similitud y el punto impartial de 0.5 a 1. Los usuarios pueden determinar el grado de divergencia desde el punto impartial para su resultado actualmente generado. Un valor de 0 significa neutralidad, lo que indica que el resultado generado favorece tanto el tipo de letra como las imágenes. Por el contrario, los valores más altos indican un mayor grado de divergencia hacia el tipo de letra o las imágenes, dependiendo de la dirección específica.

5.5 iteración

Aunque la iteración es a lo largo del proceso, identificamos tres patrones de iteración principales.

5.5.1 Regeneración para un nuevo diseño. Las herramientas anteriores a menudo permiten a los creadores eliminar resultados insatisfactorios, pero pocos tienen como objetivo mejorar el rendimiento regenerado para cumplir con la intención de los creadores. Para abordar este desafío, Typedance utiliza la retroalimentación humana implícita y explícita para inferir las preferencias del usuario. Inspirado en la tela [49]aprovechamos las reacciones de los usuarios hacia los resultados generados como una pista de preferencia del usuario. Al analizar la retroalimentación positiva de los resultados preservados y la retroalimentación negativa de las deleciones, el modelo generativo en la tipedura ajusta dinámicamente los pesos en la capa de autoatención. Esta incorporación iterativa de la retroalimentación humana permite el refinamiento del modelo generativo a lo largo del tiempo. Además, Typedance proporciona a los usuarios formas más explícitas de realizar ajustes, incluidos un mensaje textual y un management deslizante que permite a los usuarios controlar el equilibrio entre tipos de letra e imágenes.

5.5.2 Refinamiento en el espectro de Tipo-Imagery. Typedance proporciona un enfoque refinado para refinar iterativamente sus diseños a lo largo del espectro de imagería tipo. Además de la métrica cuantitativa identificada en el componente de evaluación, Typedance permite a los creadores hacer ajustes precisos con el mismo management deslizante. Como se muestra en la Fig. 5 (c), dividimos la distancia entre el punto impartial y el tipo de letra y las imágenes en 20 intervalos iguales, cada uno representando 0.05. Estas pequeñas interpolaciones preservan la estructura basic y permiten ajustes incrementales. Al arrastrar el management deslizante, los creadores pueden establecer su punto de valor deseado entre el tipo de letra y las imágenes, logrando una estética equilibrada.

Específicamente, para priorizar las imágenes, comenzamos con el diseño precise como la imagen inicial y la inyectamos en el modelo de difusión con el conjunto de resistencia al punto de valor deseado. Este proceso empuja la imagen generada hacia el extremo de las imágenes, lo que resulta en un diseño más rico semánticamente. Por el contrario, para enfatizar el tipo de letra, utilizamos el mapa de saliente del tipo de letra en el espacio de píxeles para filtrar las regiones relevantes de la imagen. Esta imagen modificada se alimenta en el modelo generativo para garantizar una transición suave hacia el extremo tipográfico.

5.5.3 Editabilidad para elementos en el diseño ultimate. Se requiere un ajuste más de grano fino para realizar cambios matizados en un resultado casi satisfactorio, como eliminar un elemento en el resultado generado. Para lograr este nivel de edición, convertimos la imagen de píxel a espacio vectorial. Por lo tanto, los creadores obtienen la capacidad de manipular cada elemento particular person en su diseño, permitiéndoles eliminar, escalar, girar y cambiar los colores según sea necesario.

Autores:

(1) Shishi Xiao, Universidad de Ciencia y Tecnología de Hong Kong (Guangzhou), China;

(2) Liangwei Wang, Universidad de Ciencia y Tecnología de Hong Kong (Guangzhou), China;

(3) Xiaojuan MA, Universidad de Ciencia y Tecnología de Hong Kong, China;

(4) Wei Zeng, Universidad de Ciencia y Tecnología de Hong Kong (Guangzhou), China.

Este documento es