El brillo de la pantalla de su computadora portátil atraviesa la oscuridad de su dormitorio. 2:47 am. Los dedos de Sarah Chen se ciernen sobre el botón de actualización, temblando ligeramente de demasiado cafeína y muy poco sueño. Hacer clic. El grado se materializa, un número marcado que se siente como un veredicto transmitido por algún tribunal invisible. Se ha juzgado su ensayo sobre literatura poscolonial, semanas de análisis cuidadoso que explora la rebelión lingüística de Achebe y las innovaciones narrativas de Adichie. Disecado. Anotado.

Por una máquina que nunca ha llorado leer “Las cosas se desmoronan”.

Esta escena se repite a través de miles de universidades todas las noches. Los estudiantes que reciben calificaciones de sistemas que operan en las sombras, jueces algorítmicos que nunca duermen, nunca dudan, nunca sienten el peso de las historias humanas integradas en el trabajo académico. Hemos entrado en una period en la que la inteligencia synthetic no solo ayuda a la educación, sino que también es educación.

La transformación es impresionante en su alcance. Los sistemas de calificación que procesan las presentaciones más rápido de lo que cualquier humano podrían soñar. Programas de tutoría que se adaptan a los estilos de aprendizaje particular person con precisión matemática. Diseños de cursos optimizados por algoritmos que detectan brechas de conocimiento antes de que los estudiantes incluso se den cuenta de que existen. La promesa brilla como Idiot’s Gold: Educación personalizada a escala sin precedentes, eficiencia que podría democratizar el aprendizaje durante millones.

Pero rasca debajo de esta chapa tecnológica, y encontrarás preguntas que hacen que los educadores pierdan el sueño.

¿Qué sucede cuando un estudiante no está de acuerdo con una calificación asignada? ¿Puedes discutir con un algoritmo? Cuando las máquinas malinterpretan el contexto cultural o no reconocen el brillo creativo que no se ajusta a los patrones predeterminados, ¿quién tiene responsabilidad? ¿La inteligencia synthetic representa el futuro de la evaluación justa, o la muerte de los matices educativos?

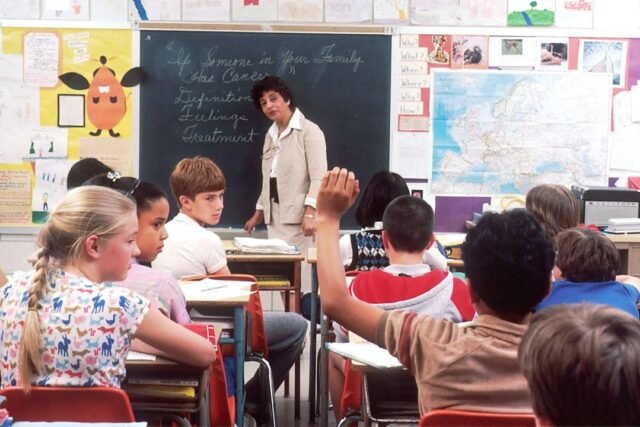

Estas no son preocupaciones teóricas flotando en revistas académicas. Están reestructurando el ADN de la educación superior en este momento, transformando la relación sagrada entre el maestro y el alumno en algo sin precedentes: un triángulo que involucra a alumnos humanos, educadores humanos y mentes artificiales que procesan pero que realmente no entienden.

La revolución silenciosa: cómo las máquinas aprendieron a calificar

Entra en cualquier edificio de informática a las 3 am, y los escucharás: el zumbido tranquilo de los servidores que procesan flujos interminables de código de estudiante. Los sistemas de clasificación automática han sido los héroes no reconocidos de la educación de programación durante décadas, máquinas elegantes que prueban, evalúan y obtienen con precisión mecánica.

La Dra. Briana Morrison conoce este mundo íntimamente. Como profesora asociada en la Universidad de Virginia y copresidenta de la Junta de Educación de ACM, ha sido testigo de la evolución de primera mano. “Dentro de la educación informática, hemos utilizado auficiadores o sistemas informáticos para evaluar las presentaciones de los estudiantes (es decir, los programas que envían para la tarea) durante años”, explica con el tono de hecho de alguien que describe una herramienta acquainted. “Las calificaciones siempre son imparciales”.

Estos sistemas operan con hermosa simplicidad:

pitón

import unittest

def student_function(x):

return x * 2

class TestStudentFunction(unittest.TestCase):

def test_double(self):

self.assertEqual(student_function(2), 4)

self.assertEqual(student_function(5), 10)

unittest.major()

Aporte. Proceso. Producción. Perfección binaria.

Pero aquí es donde nuestra historia se convierte en un territorio inexplorado. Las instituciones educativas ya no se contentan con el código de calificación. Quieren que la IA evalúe los ensayos que lidian con las preguntas existenciales. Proyectos creativos que desafían la estandarización. Publicaciones de discusión que revelan la complejidad desordenada del pensamiento humano.

Se están implementando algoritmos de aprendizaje automático para personalizar el aprendizaje en escalas que harían que los educadores tradicionales se marearan. ChatGPT responde a las preguntas de los estudiantes sobre la mecánica cuántica. GitHub Copilot ayuda a los aspirantes a programadores a escribir sus primeros algoritmos. Gradescope procesa miles de exámenes simultáneamente, identificando patrones que los calificadores humanos podrían perderse.

La eficiencia es innegable. Las implicaciones? Espantoso.

Las herramientas que una vez complementan el juicio humano lo reemplazan cada vez más. Y a diferencia del mundo claro de las pruebas de código, la evaluación subjetiva implica matices, contexto y comprensión cultural que incluso los sistemas de IA más sofisticados luchan por comprender.

La pregunta inquietante de la educación no es si AI continuará su marcha hacia nuestras aulas. Es si estamos preparados para lo que podríamos perder en el proceso.

La apuesta de la calificación probabilística

Existe un abismo entre la evaluación tradicional de AI y clasificación automática y una moderna evaluación de IA, un abismo que la mayoría de los educadores no han reconocido completamente. Los sistemas tradicionales son deterministas. Alimentarlos entradas idénticas, obtener salidas idénticas. Cada vez. Sistemas de IA generativos? Son criaturas de probabilidad, aproximaciones estadísticas envueltas en la ilusión de la certeza.

Morrison dibuja esta distinción con la precisión de un cirujano: “Creo que el sistema al que se refiere es uno basado exclusivamente en la calificación con AI … que yo sepa, nadie en la educación informática está utilizando uno de estos sistemas”.

Aún no.

Su advertencia conlleva el peso de la profecía: “Incluso si uno fuera entrenado solo en el contenido del curso, no hay garantía de que el texto y el grado probabilístico generados coincidan con el del experto o el teacher”.

Think about este escenario: un estudiante presenta un análisis brillante de la metáfora de Shakespeare. El sistema AI, tratado en miles de ensayos similares, procesa la sumisión a través de capas de redes neuronales, cada capa agrega su propia incertidumbre estadística. La calificación last no surge del razonamiento lógico sino del reconocimiento de patrones, de la mejor suposición estadística del sistema sobre lo que podría decidir un evaluador humano.

Considere cómo esto podría funcionar en la práctica:

json

{

"immediate": "Grade this essay on World Struggle II: [essay_text]",

"temperature": 0.7,

"max_tokens": 200

}

Esa inocua parámetro de “temperatura” controla la aleatoriedad. El mismo ensayo podría recibir diferentes grados dependiendo de los cambios de humor computacionales invisibles para todos los involucrados. El sistema podría favorecer ciertas frases el martes y penalizarlas el miércoles, todo mientras mantiene la aparición de una evaluación consistente.

Esto no es una falla técnica: es un desafío basic para todo lo que creemos sobre la evaluación justa. Cuando las calificaciones se vuelven probabilísticas, ¿qué sucede con el concepto de evaluación objetiva? ¿Cómo mantenemos los estándares académicos cuando el estándar en sí mismo fluctúa con cada evaluación algorítmica?

Las implicaciones se extienden hacia afuera como piedras arrojadas a agua fija. Si los sistemas de IA no pueden garantizar una evaluación consistente de un trabajo idéntico, ¿cómo pueden mantener la equidad en diferentes estudiantes, diferentes antecedentes, diferentes formas de expresar conocimiento? La base misma de la evaluación académica (consistencia, equidad, transparencia) aborda el desmoronamiento.

La amplificación de los prejuicios antiguos

La verdad más incómoda de la educación se encuentra en la intersección de la tecnología y el sesgo: los sistemas de IA no eliminan los prejuicios humanos: lo amplifican a una escala sin precedentes. Cada algoritmo se convierte en un espejo que refleja los sesgos integrados en sus datos de capacitación, y los sistemas educativos de IA no son una excepción a esta reproducción digital de desigualdades históricas.

La advertencia de Morrison corta el corazón del asunto: “Las herramientas generativas de IA son tan buenas como sus datos de entrenamiento, que deben estar libres de sesgo”.

Pero los datos sin sesgo son un unicornio, en realidad, imposible. Los registros académicos históricos tienen prejuicios integrados contra ciertos estilos de escritura, perspectivas culturales y hablantes no nativos. Cuando AI aprende de esta historia contaminada, perpetúa la discriminación con la eficiencia de una máquina y la invisibilidad de una sombra.