Tabla de enlaces

-

Introducción

-

Trabajo relacionado

2.1 Diseño de logotipo tipográfico semántico

2.2 Modelo generativo para el diseño computacional

2.3 Herramienta de autoría de diseño gráfico

-

Estudio formativo

3.1 flujo de trabajo normal y desafíos

3.2 Preocupaciones en la participación generativa del modelo

3.3 Espacio de diseño del trabajo de tipografía semántica

-

Consideración de diseño

-

Típica y ideación 5.1

5.2 Selección

5.3 Generación

5.4 Evaluación

5.5 iteración

-

Tutorial de la interfaz y 6.1 etapa previa a la generación

6.2 Etapa de generación

6.3 Etapa posterior a la generación

-

Evaluación y comparación de referencia 7.1

7.2 Estudio de usuarios

7.3 Análisis de resultados

7.4 Limitación

-

Discusión

8.1 Diseño personalizado: colaboración consciente de la intención con AI

8.2 Incorporación del conocimiento de diseño en herramientas de soporte de creatividad

8.3 flujo de trabajo de diseño orientado a usuario de mezcla

-

Conclusión y referencias

5.3 Generación

5.3.1 Generación de entrada. Esta sección describe las tres entradas requeridas para el proceso de generación. La primera entrada es el tipo de letra seleccionado 𝐼𝑡, que sirve como la imagen de origen para el modelo de difusión. La segunda entrada es el mensaje del usuario opcional 𝑇𝑝, que les permite expresar explícitamente su intención, como el estilo específico que desean. La tercera entrada consiste en los factores de diseño extraídos de la imagen seleccionada 𝐼𝑖.

Semántica. El aviso textual es un medio accesible e intuitivo para que los creadores instruyan la IA, que también ofrece una forma de incorporar imágenes en el proceso de generación. Sin embargo, es laborioso describir una cantidad significativa de información dentro de las limitaciones de una longitud rápida limitada. Typedance resuelve este problema extrayendo automáticamente la descripción de las imágenes seleccionadas. Describir las imágenes seleccionadas implica un proceso de inversión de texto que abarca múltiples dimensiones de semántica concreta. Una de las destacadas semánticas es la comprensión visible normal de una escena. Por ejemplo, en la Fig. 4, la descripción de la escena es “Un jarrón amarillo con flores rosadas”. Capturamos esta información visible explícita (objeto, diseño, and so forth..) Usando blip [29]un modelo de lenguaje de visión que sobresale en las tareas de subtítulos de imágenes. Además, el estilo Las imágenes, especialmente cuando se trata de ilustraciones o pinturas, pueden influir en gran medida en su representación y servir como una fuente común de inspiración para los creadores. El estilo de la caja en la figura 4 es “Estudio de fotos de Nonetheless Life con estilo de realismo simplificado”. Tal estilo específico se deriva de recuperar descripciones relevantes con alta similitud en una gran base de datos rápida. Por lo tanto, la semántica completa de las imágenes incluye la escena y el estilo. Para mejorar la escalabilidad de la interfaz, extraemos palabras clave de la semántica detallada. Los creadores aún pueden acceder a la versión completa al pasar el ronco sobre las palabras clave.

Colour. Typedance utiliza la agrupación KNN [16] extraer cinco colores primarios de las imágenes seleccionadas. Estas especificaciones de shade se aplican luego en el proceso de generación posterior. Para preservar la relación de colorización semántica, los colores extraídos se transforman en una paleta 2D que incluye información espacial. Esto asegura que la salida generada mantenga una composición de shade significativa y coherente.

Forma. La forma del tipo de letra puede tomar una distorsión estética para incorporar imágenes ricas, como se demuestra en nuestro estudio formativo. Para lograr esto, primero aprovechamos la detección de borde para reconocer el contorno de las imágenes seleccionadas. Luego, muestras 20 puntos equidistantes a lo largo del contorno. Estos puntos se utilizan para deformar el esquema de la letra de forma iterativa, utilizando coordenadas bariccentric generalizadas [33]. La deformación ocurre en el espacio vectorial, lo que resulta en una forma modificada que representa imágenes gruesas y facilita la generación guiada.

Estos factores de diseño se aplican de forma independiente durante el proceso de generación. Los creadores tienen la flexibilidad de combinar estos factores de acuerdo con sus necesidades específicas, lo que permite la creación de diseños diversos y personalizados.

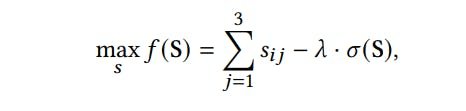

5.3.2 Discriminación de salida. Para garantizar que el resultado generado se alinee con la intención de los creadores, Typedance emplea una estrategia que filma buenos resultados basados en tres puntajes. Como se ilustra en la Fig. 4, apuntamos al resultado generado 𝐼𝑔 para lograr una puntuación relativamente equilibrada en los triángulos compuestos de tipo de letra, imágenes y el aviso opcional del usuario. La puntuación de tipo Tipo de tipo de letra 𝑠1 se determina comparando los mapas de prominencia del tipo de letra seleccionado y el resultado generado. Los mapas de prominencia son imágenes en escala de grises que resaltan objetos visualmente sobresalientes en una imagen mientras descuidan otra información redundante. Extraemos los mapas de saliente para el tipo de letra y el resultado generado y luego comparamos su similitud en cuanto a píxel. La puntuación de imágenes 𝑠2 se deriva de la similitud de coseno entre los incrustaciones de imagen de la imagen de entrada 𝐼𝑖 y el resultado generado 𝐼𝑔. Del mismo modo, obtenemos la puntuación rápida 𝑠3 calculando la similitud cosena entre la inserción de la imagen del resultado generado 𝐼𝑔 y la incrustación de texto de la solicitud del usuario 𝑇𝑝. Utilizamos el modelo de clip previamente capacitado para obtener la imagen y los incrustaciones de texto debido a su espacio multimodal alineado. Denotamos 𝑠𝑖 = {𝑠𝑖1, 𝑠𝑖2, 𝑠𝑖3}, donde 𝑖 representa el resultado 𝑖-th en una ronda de generación. Para filtrar los resultados que se alinean principalmente con la intención de los creadores, utilizamos una función de objetivo múltiple que maximiza la suma de los puntajes y minimiza la varianza entre ellos. La función se outline de la siguiente manera:

donde s es el conjunto de puntaje de todos los resultados generados, y 𝜎 (s) calcula la varianza de los puntajes. El 𝜆 es un issue de ponderación utilizado para equilibrar la puntuación complete y la varianza, que se establece empíricamente como 0.5. Según este criterio, la tipEdance muestra el resultado superior 1 en la interfaz cada ronda y se regenera para obtener un complete de cuatro resultados.

Autores:

(1) Shishi Xiao, Universidad de Ciencia y Tecnología de Hong Kong (Guangzhou), China;

(2) Liangwei Wang, Universidad de Ciencia y Tecnología de Hong Kong (Guangzhou), China;

(3) Xiaojuan MA, Universidad de Ciencia y Tecnología de Hong Kong, China;

(4) Wei Zeng, Universidad de Ciencia y Tecnología de Hong Kong (Guangzhou), China.

Este documento es