¿Pueden sus herramientas de IA realmente trabajar juntas, o todavía están atrapados en silos? Con el nuevo protocolo de agente a agente (A2A) de Google, los días de los agentes de IA aislados están numerados. Este estándar emergente permite que los agentes especializados se comuniquen, delegan y colaboren, que indican una nueva period de sistemas de IA modulares y escalables. Así es como A2A podría transformar sus flujos de trabajo, y por qué hacerlo observable es tan importante como hacerlo posible.

Por qué agente a agente es un avance para la IA colaborativa

Para entender por qué A2A es un gran avance, ayuda a ver cómo han evolucionado los agentes de IA. Hasta ahora, la mayoría de los agentes se han basado en el Protocolo de contexto del modelo (MCP), un mecanismo que les permite enriquecer sus respuestas llamando a herramientas, API o funciones externas en tiempo actual.

MCP ha cambiado el juego, conectando a los agentes con todo, desde bases de conocimiento y paneles de análisis hasta servicios externos como Github y Jira, dándoles mucho más contexto de lo que se almacena en sus datos de entrenamiento.

Sin embargo, MCP sigue siendo fundamentalmente un arquitectura de un solo agente: El agente se mejora a sí mismo llamando a las herramientas.

Google A2A El protocolo lleva las cosas un paso más allá. Presenta un estándar de cómo múltiples agentes de IA pueden descubrir, comprender y colaborar entre sí, delegando partes de una consulta al agente más capaz de resolverla.

En un mundo donde los agentes están siendo capacitados para dominios de nicho (por ejemplo, finanzas, atención médica, atención al cliente o DevOps), este modelo de colaboración de múltiples agentes podría redefinir cómo construimos aplicaciones inteligentes, modibles, escalables y altamente especializadas.

La industria ya se ha vuelto multi – Ai es el próximo

Para apreciar por qué A2A es un paso tan significativo, ayuda a alejar y ver la tendencia más amplia a través de la infraestructura moderna:

En todo DNS, CDN, Cloud e incluso AI, hemos visto un cambio de confiar en un solo proveedor para orquestar ecosistemas de múltiples proveedores que optimizan para el rendimiento, el costo, la confiabilidad y el ajuste de casos de uso.

- DNS: Donde una vez un solo proveedor de DNS period la norma, muchas empresas ahora usan multid-DNS Estrategias para una resolución más rápida, una mejor cobertura geográfica y conmutación por error incorporada.

- CDN: El movimiento de un CDN a arquitecturas multi-CDN Permite a las empresas enrutar el tráfico en función de la latencia, la región o el costo, mientras mejoran la redundancia y el rendimiento en el borde.

- Nube: Con AWS, Azure, GCP y otros que ofrecen servicios diferenciados, múltiple ahora es una elección estratégica. Los equipos eligen los mejores servicios de clase en los proveedores y reducen la dependencia de cualquier proveedor único.

Esta estrategia “múltiple” no se trata solo de la gestión de riesgos, sino que se trata de especialización y optimización.

Ahora, en el dominio AI, somos testigos del mismo patrón. Mientras que los primeros usuarios eligieron un modelo de base único (por ejemplo, GPT-4, Gemini, Claude), la próxima generación de sistemas inteligentes probablemente sea sistemas de agentes múltiples. Un agente podría estar optimizado para la interpretación de datos, otro para la toma de decisiones y otro para el cumplimiento del dominio.

Inside A2A: cómo los agentes descubren y delegan en tiempo actual

El protocolo A2A de Google permite un marco donde los agentes pueden colaborar dinámicamente. Piense en este escenario:

Un usuario pregunta: “¿Cuál es el clima en Nueva York?”

El Agente 1 recibe la consulta pero carece de acceso a datos meteorológicos en tiempo actual. Sin embargo, sabe (a través del protocolo A2A) que el Agente 2 está especializado en actualizaciones meteorológicas en vivo. Consulta el agente 2, obtiene los datos precisos y los sirve al usuario, sin ser vistinado.

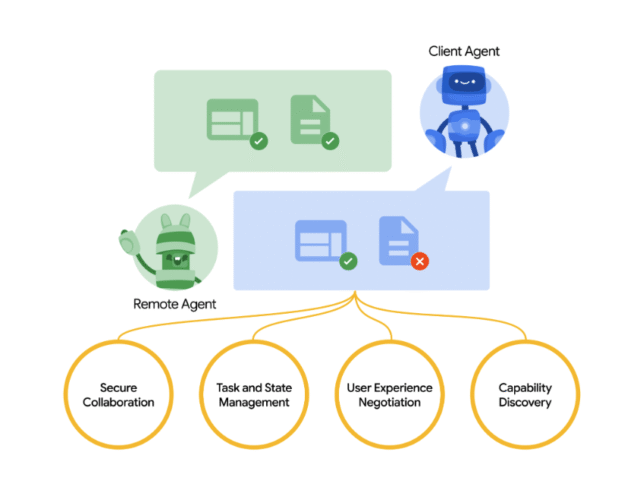

Esta interacción funciona con algunos conceptos clave:

- Agente anfitrión (agente cliente): El agente iniciador que recibe la consulta del usuario y la delega si es necesario.

- Agente remoto: Un agente capaz de cumplir tareas especializadas cuando se invoca por otra.

- Tarjeta de agente: Un descriptor de metadatos basado en JSON publicado por agentes para anunciar sus capacidades y puntos finales: obtener otros agentes descubren y enrutan las tareas de manera inteligente.

A2A facilita la comunicación entre un agente “cliente” y un agente “remoto”.

Intenté implementar una interacción básica de A2A localmente utilizando la especificación de código abierto de Google. Es notablemente modular y extensible, al igual que la comunicación de servicio a servicio de API revolucionada, A2A puede hacer lo mismo para la orquestación de agente a agente.

Aquí hay una instantánea de mi implementación native:

El agente remoto escucha en el puerto 8001, listo para recibir tareas. Anuncia sus capacidades a través de una tarjeta de agente y ejecuta solicitudes entrantes en consecuencia.

El agente anfitrión Primero descubre primero al agente remoto, recupera sus capacidades y envía una solicitud de consulta al punto last apropiado definido en la tarjeta de agente. Luego recibe y devuelve la respuesta last.

Lograr la visibilidad de extremo a extremo en sistemas de agentes múltiples

Los sistemas de IA de múltiples agentes aportan nuevas capacidades poderosas, pero también nuevos riesgos. En las arquitecturas tradicionales, la observabilidad se detiene en el borde de su pila. Pero en un mundo de A2A, una sola solicitud de usuario podría pasar a través de una cadena de agentes, cada uno que se ejecuta en diferentes sistemas, propiedad de diferentes equipos y depende de diferentes API.

Cada interacción de agente es esencialmente una llamada de servicio. Eso significa:

- Latencia agregada

- Más puntos de falla

- Mayor complejidad cuando algo sale mal

Tome un chatbot para una aplicación de reserva de boletos. Puede confiar en microservicios internos para la disponibilidad y los pagos, pero llamar a un agente meteorológico o agente de vuelo que usa A2A. Si uno de esos agentes es lento o no responde, toda la experiencia se degrada. Y es difícil arreglar lo que no puedes ver.

Aquí es donde importa la visibilidad. Al mapear su servicio y dependencias de agentes, internos y externas, puede:

- Identificar dónde se producen ralentizaciones o errores

- Comprender cómo los agentes interactúan a través de la cadena

- Aislar rápidamente las causas raíz cuando algo falla

Herramientas como el mapa de pila de Web de Catchpoint ayudan a los equipos a visualizar estos flujos. Aprovecha el monitoreo del rendimiento de Web (IPM) para ilustrar cómo las solicitudes fluyen a través de componentes internos y a las API de agentes externas, dejando en claro dónde existen dependencias y dónde pueden surgir problemas.

Mapa de la pila de Web de Catchpoint

Así como evolucionamos de un solo CDN a multi-CDN, o de aplicaciones monolíticas a microservicios, ahora estamos entrando en una period de inteligencia múltiple. Y al igual que aprendimos a monitorear ese sistema distribuido, ahora tendremos que monitorear los sistemas de múltiples agentes con el mismo rigor.

Porque el futuro no es solo AI, está trabajando juntos. Modular. distribuido, colaborativo. Y IPM es lo que hace posible esa visibilidad.

Aprenda más: Vea cómo el mapa de la pila de Web puede ayudarlo a mantenerse por delante de las interrupciones: reduzca una demostración hoy.