Tabla de enlaces

Resumen y 1. Introducción

-

Trabajo relacionado

2.1 Texto a la generación vocal

2.2 Generación de texto a movimiento

2.3 Generación de audio a movimiento

-

Conjunto de datos de estrago

3.1 subconjunto de rap-vocal

3.2 subconjunto de movimiento de rap

-

Método

4.1 Formulación de problemas

4.2 MOVIMIENTO TOKENIZER VQ-VAE

4.3 tokenizador de audio vocal2unit

4.4 Modelado basic de autosuficiencia

-

Experimentos

5.1 Configuración experimental

5.2 Análisis de resultados principales y estudio de ablación 5.3

-

Conclusión y referencias

A. Apéndice

2.1 Texto a la generación vocal

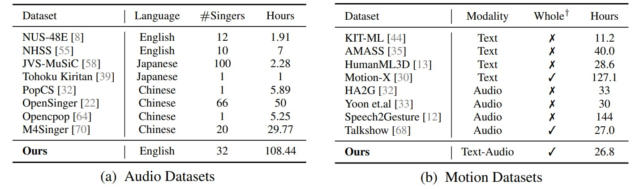

Conjunto de datos de texto a audio. Existe varios conjuntos de datos vocales de canto, pero cada uno tiene limitaciones. Por ejemplo, POPCS [32] y OpenSinger [22] se limitan al chino, mientras que NUS-48E [8] y NHSS [55] tener solo unas pocas horas de canciones. Sin embargo, JVS-Music [58] y NUS-48E [8] Ofrezca unas horas de canciones de docenas de cantantes, mientras que OpenSinger [22] Proporciona una colección más extensa con decenas de horas de un solo cantante. En explicit, nuestro conjunto de datos representa el primero en ser seleccionado específicamente para canciones de rap de múltiples cantantes con 108 horas.

Modelos de texto a vocal. Avances recientes en modelos de texto a voz (TTS), incluido Wavnet [40]FastSpeech 1 y 2 [52, 51]y come [7]han mejorado significativamente la calidad del habla sintetizada. Sin embargo, la síntesis de voz de canto (SVS) presenta un mayor desafío debido a su dependencia de puntajes y letras musicales adicionales. Modelos de generación recientes [32, 16, 16, 74, 26] Realizar excelentemente en la generación de voces de canto. Sin embargo, su desempeño tiende a deteriorarse al encontrar datos fuera de distribución. Para manejar esto, Stylesinger [73] Presenta un adaptador de estilo residual y una normalización de la capa de modelado de incertidumbre para manejar esto.

2.2 Generación de texto a movimiento

Conjunto de datos de texto a cámara. Conjuntos de datos de texto de texto actuales, como el equipment [44]Acumular [35]y humano [13]están limitados por una cobertura de datos limitada, que generalmente abarcan solo decenas de horas y carecen de representación de movimiento de todo el cuerpo. Para superar estas deficiencias, Movement-X [30] se desarrolló, proporcionando un extenso conjunto de datos que abarca movimientos de todo el cuerpo.

Modelos de texto a cámara. Modelos de texto a cámara [43, 71, 14, 13, 34, 4] han ganado popularidad para su conveniencia de usuario. Los avances recientes se han centrado en los modelos de difusión [71, 25, 61]que, a diferencia de los modelos de generación determinista [2, 11]habilite la generación de salida de grano más fino y diversa. Chen et al. [4] propuso un modelo de difusión basado en el movimiento para mejorar la calidad generativa y reducir los costos computacionales. Sin embargo, la desalineación entre el lenguaje pure y los movimientos humanos presenta desafíos. Lu et al. [34] introdujo el marco de generación de movimiento de cuerpo entero alineado con texto para abordar estos problemas generando expresiones faciales, gestos de manos y movimientos corporales de alta calidad, diversas y coherentes simultáneamente.

2.3 Generación de audio a movimiento

Conjunto de datos de audio a movimiento. Los conjuntos de datos de copreanja se pueden clasificar en 1: pseudo marcado (PGT) y 2: capturado con movimiento (MOCAP). Conjuntos de datos PGT [3, 15, 12, 68] utilizar puntos clave 2D o 3D desconectados para

Representa el cuerpo, permitiendo extraer a un costo más bajo pero con precisión limitada. Por otro lado, los conjuntos de datos MOCAP proporcionan anotaciones para partes limitadas del cuerpo, y algunos se centran únicamente en la cabeza [9, 5, 65] o el cuerpo [57, 10]. Diferenciando de ellos, beatx [31] Contiene datos de malla de cabeza y cuerpo. Sin embargo, estos conjuntos de datos generalmente se centran en la generación de discursos a movimiento. Nuestro rapverse, en contraste, contiene datos de movimiento de texto de texto emparejados, lo que permite el movimiento simultáneo y la generación vocal.

Modelos de audio a movimiento. Modelos de audio a movimiento [59, 56, 72, 31, 68] Su objetivo a producir movimiento humano de Audio Innputs. Reconociendo la intrincada relación entre el audio y la cara humana, TalkShow [68] Genera por separado partes de la cara y otras partes del cuerpo. Sin embargo, este enfoque exhibe limitaciones, como la ausencia de generar el cuerpo inferior y el movimiento international. Emage [31] Utiliza gestos enmascarados junto con voces para una generación. Sin embargo, nuestro modelo va un paso más al ser el primero en generar datos de movimiento de audio emparejados directamente del texto.

Autores:

(1) Jiaben Chen, Universidad de Massachusetts Amherst;

(2) Xin Yan, Universidad de Wuhan;

(3) Yihang Chen, Universidad de Wuhan;

(4) Siyuan Cen, Universidad de Massachusetts Amherst;

(5) Qinwei MA, Universidad de Tsinghua;

(6) Haoyu Zhen, Universidad de Shanghai Jiao Tong;

(7) Kaizhi Qian, MIT-IBM Watson AI Lab;

(8) mentir Lu, Dolby Laboratories;

(9) Chuang Gan, Universidad de Massachusetts Amherst.