He creado más de 12 sistemas de agentes de inteligencia synthetic de producción en el desarrollo, devops y operaciones de datos. He aquí por qué la exageración precise sobre los agentes autónomos es matemáticamente imposible y lo que realmente funciona en la producción.

Todos dicen que 2025 es el año de los agentes de IA. Los titulares están en todas partes: “La IA autónoma transformará el trabajo”, “Los agentes son la próxima frontera”, “El futuro es agente”. Mientras tanto, pasé el último año construyendo muchos sistemas de agentes diferentes que realmente funcionan en producción. Y eso es exactamente por eso que estoy apostando contra la exageración precise.

No soy una escritura escéptica de IA desde la barrera. Durante el año pasado, he construido más de una docena de sistemas de agentes de producción en todo el ciclo de vida del desarrollo de software program:

Agentes de desarrollo: Generadores de UI que crean componentes reactos funcionales desde el lenguaje pure, los agentes de refactorización de código que modernizan las bases de código heredadas, los generadores de documentación que mantienen documentos API automáticamente y funcionan generadores que convierten las especificaciones en implementaciones de trabajo.

Agentes de datos e infraestructura: Agentes de operación de la base de datos que manejan consultas y migraciones complejas, sistemas de IA DevOps Automation que gestionan la infraestructura como código en múltiples proveedores de nubes.

Agentes de calidad y proceso: Las tuberías de CI/CD con alimentación de IA que solucionan problemas de pelusa, generan suites de prueba integrales, realizan revisiones de código automatizadas y crean solicitudes detalladas de extracción con las descripciones adecuadas.

Estos sistemas funcionan. Envían valor actual. Ahorran horas de trabajo handbook todos los días. Y eso es precisamente por eso que pienso mucho en lo que está escuchando sobre que 2025 es “el año de los agentes” pierde realidades clave.

Tl; dr: tres verdades duras sobre agentes de IA

Después de construir más de 12 sistemas de producción, esto es lo que he aprendido:

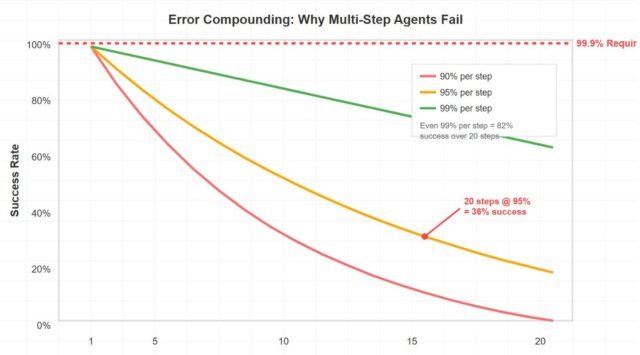

1. Tasas de error Compuesto exponencialmente en flujos de trabajo de múltiples pasos. 95% de confiabilidad por paso = 36% de éxito en 20 pasos. La producción necesita 99.9%+.

- Las ventanas de contexto crean costos de token cuadrático. Las conversaciones largas se vuelven prohibitivamente caras a escala.

- El verdadero desafío no son las capacidades de IA, está diseñando herramientas y sistemas de retroalimentación que los agentes realmente pueden usar de manera efectiva.

La realidad matemática de la que nadie habla

Aquí está la verdad incómoda que cada compañía de agentes de IA está bailando: el compuesto de errores hace que los flujos de trabajo de varios pasos autónomos sean matemáticamente imposibles a escala de producción.

Hagamos los cálculos. Si cada paso en un flujo de trabajo de agente tiene una confiabilidad del 95%, lo cual es optimista para los LLM actuales, entonces:

- 5 pasos = 77% de tasa de éxito

- 10 pasos = 59% de tasa de éxito

- 20 pasos = 36% de tasa de éxito

Los sistemas de producción necesitan 99.9%+ confiabilidad. Incluso si alcanza mágicamente una confiabilidad del 99% por paso (que nadie tiene), solo tiene un éxito del 82% en 20 pasos. Este no es un problema rápido de ingeniería. Este no es un problema de capacidad de modelo. Esta es la realidad matemática.

Mi agente de DevOps funciona precisamente porque en realidad no es un flujo de trabajo autónomo de 20 pasos. Son 3-5 operaciones discretas e independientemente verificables con puntos de reversión explícitos y puertas de confirmación humana. El “agente” maneja la complejidad de generar código de infraestructura, pero el sistema está diseñado en torno a las limitaciones matemáticas de confiabilidad.

Cada sistema de agente exitoso que he creado sigue el mismo patrón: contextos limitados, operaciones verificables y puntos de decisión humanos (a veces) en las uniones críticas. En el momento en que intentas encadenar más que un puñado de operaciones de forma autónoma, las matemáticas te matan.

La economía token que no se suma

Hay otra realidad matemática que los evangelistas del agente ignoran convenientemente: las ventanas de contexto crean escala cuadrática de costos que hace que los agentes de conversación sean económicamente imposibles.

Esto es lo que realmente sucede cuando construyes un agente “conversacional”:

- Cada nueva interacción requiere procesar todo el contexto anterior

- La escala de costos de token cuadráticamente con la longitud de la conversación

- Una conversación de 100 giros cuesta $ 50-100 solo en tokens

- Multiplicar por miles de usuarios y estás viendo una economía insostenible

Aprendí esto de la manera difícil al crear prototipos de un agente de base de datos conversacional. Las primeras interacciones fueron baratas. Para la consulta 50 en una sesión, cada respuesta costaba múltiples dólares, más del valor que proporcionó. La economía simplemente no funciona para la mayoría de los escenarios.

Mi agente de generación de funciones tiene éxito porque es completamente estancado: descripción → función → hecho. No hay contexto para mantener, sin conversación para rastrear, sin explosión de costos cuadráticos. No es una experiencia de “chat con su código”, es una herramienta enfocada que resuelve un problema específico de manera eficiente.

Los “agentes” más exitosos en la producción no son conversacionales en absoluto. Son herramientas inteligentes y limitadas que hacen bien una cosa y se salen del camino.

Incluso si resuelve los problemas matemáticos, alcanza un tipo diferente de muro: construir herramientas de grado de producción para agentes es una disciplina de ingeniería completamente diferente que la mayoría de los equipos subestiman.

Las llamadas de herramientas en sí mismas son bastante precisas ahora. El verdadero desafío es el diseño de herramientas. Cada herramienta necesita ser cuidadosamente elaborada para proporcionar los comentarios correctos sin abrumar la ventana de contexto. Necesitas pensar en:

- ¿Cómo sabe el agente si una operación tuvo éxito parcialmente? ¿Cómo se comunica los cambios de estado complejos sin quemar tokens?

- Una consulta de la base de datos puede devolver 10,000 filas, pero el agente solo necesita saber “consulta que tiene éxito, 10k resultados, aquí están los primeros 5”. Diseñar estas abstracciones es un arte.

- Cuando una herramienta falla, ¿qué información necesita recuperarse el agente? Muy poco y está atascado; Demasiado y desperdicias el contexto.

- ¿Cómo manejan las operaciones que se afectan entre sí? Transacciones de base de datos, bloqueos de archivos, dependencias de recursos.

Mi agente de base de datos funciona no porque las llamadas de la herramienta no sean confiables, sino porque pasé semanas diseñando herramientas que se comunican de manera efectiva con la IA. Cada herramienta devuelve comentarios estructurados que el agente realmente puede usar para tomar decisiones, no solo las respuestas de API sin procesar.

Las compañías que prometen “simplemente conectan sus API y nuestro agente lo resolverán” no han hecho este trabajo de ingeniería. Están tratando herramientas como interfaces humanas, no interfaces de IA. El resultado son los agentes que técnicamente hacen llamadas de API exitosas pero que en realidad no pueden lograr flujos de trabajo complejos porque no entienden lo que sucedió.

El secreto sucio de cada sistema de agentes de producción es que la IA está haciendo quizás el 30% del trabajo. El otro 70% es la ingeniería de herramientas: diseño de interfaces de retroalimentación, gestionar el contexto de manera eficiente, manejar fallas parciales y construir mecanismos de recuperación que la IA realmente puede comprender y usar.

La verificación de la realidad de integración

Pero digamos que resuelve los problemas de confiabilidad y la economía. Todavía tienes que integrarte con el mundo actual, y el mundo actual es un desastre.

Los sistemas empresariales no son API limpias que esperan que los agentes de IA los orquesten. Son sistemas heredados con peculiaridades, modos de falla parcial, flujos de autenticación que cambian sin previo aviso, límites de tasa que varían según la hora del día y los requisitos de cumplimiento que no se ajustan perfectamente a las plantillas rápidas.

Mi agente de base de datos no solo “ejecuta consultas de forma autónoma”. Navega por la agrupación de conexión, maneja las reversiones de las transacciones, respeta las réplicas de solo lectura, gestiona los tiempos de espera de consultas y registra todo para los senderos de auditoría. La IA maneja la generación de consultas; Todo lo demás es la programación de sistemas tradicionales.

Las compañías que prometen “agentes autónomos que se integran con toda su pila tecnológica” son demasiado optimistas o en realidad no han intentado construir sistemas de producción a escala. La integración es donde los agentes de IA van a morir.

Lo que realmente funciona (y por qué)

Después de construir más de una docena de sistemas de agentes diferentes en todo el ciclo de vida del desarrollo de software program, he aprendido que los exitosos comparten un patrón:

- Mi agente de generación de UI funciona porque los humanos revisan cada interfaz generada antes de la implementación. La IA maneja la complejidad de traducir el lenguaje pure en componentes reactos funcionales, pero los humanos toman las decisiones finales sobre la experiencia del usuario.

- Mi agente de base de datos funciona porque confirma cada operación destructiva antes de la ejecución. La IA maneja la complejidad de traducir los requisitos comerciales en SQL, pero los humanos mantienen el management sobre la integridad de los datos.

- Mi agente de generación de funciones funciona porque opera dentro de los límites claramente definidos. Déle una especificación, recupere una función. Sin efectos secundarios, sin gestión estatal, sin complejidad de integración.

- Mi automatización de DevOps funciona porque genera infraestructura como código que puede revisarse, versionarse y retroceder. La IA maneja la complejidad de traducir los requisitos en Terraform, pero la tubería de implementación mantiene todos los mecanismos de seguridad en los que hemos aprendido a confiar.

- Mi agente de CI/CD funciona porque cada etapa tiene claros criterios de éxito y mecanismos de reversión. La IA maneja la complejidad de analizar la calidad del código y generar correcciones, pero la tubería mantiene el management sobre lo que realmente se fusiona.

El patrón es claro: la IA maneja la complejidad, los humanos mantienen el management y la ingeniería de software program tradicional maneja la confiabilidad.

Mis predicciones

Aquí está mi predicción específica sobre quién luchará en 2025:

Las startups de “agente totalmente autónomo” financiado por la empresa llegarán a la pared de la economía primero. Sus demostraciones funcionan muy bien con flujos de trabajo de 5 pasos, pero los clientes exigirán más de 20 procesos de paso que se descompongan matemáticamente. Las tasas de quemaduras aumentarán mientras intentan resolver problemas de confiabilidad insoluble.

Las compañías de software program empresarial que atornillaron “agentes de IA” en los productos existentes verán la adopción estancada. Sus agentes no pueden integrarse lo suficientemente profundamente como para manejar flujos de trabajo reales.

Mientras tanto, los ganadores serán equipos construyendo herramientas limitadas y específicas de dominio que usan IA para las partes duras mientras mantienen el management humano o los límites estrictos sobre las decisiones críticas. Piense menos “todo autónomo” y más “asistentes extremadamente capaces con límites claros”.

El mercado aprenderá la diferencia entre la IA que demos bien y la IA que envían de manera confiable. Esa educación será costosa para muchas empresas.

No estoy apostando contra AI. Apuesto contra el enfoque precise de la arquitectura del agente. Pero creo que el futuro será mucho más valioso de lo que sugiere la exageración.

Construyendo el camino correcto

Si está pensando en construir con agentes de IA, comience con estos principios:

Definir límites claros. ¿Qué puede hacer exactamente su agente y qué se entrega a los humanos o los sistemas deterministas?

Diseño para el fracaso. ¿Cómo manejas el 20-40% de los casos en los que la IA comete errores? ¿Cuáles son tus mecanismos de reversión?

Resolver la economía. ¿Cuánto cuesta cada interacción y cómo se escala eso con el uso? Los apátridos a menudo superan los estados.

Priorizar la confiabilidad sobre la autonomía. Los usuarios confían en las herramientas que funcionan consistentemente más que los sistemas de valores que ocasionalmente hacen magia.

Construir sobre bases sólidas. Use la IA para las partes duras (comprensión de la intención, la generación de contenido), pero confíe en la ingeniería de software program tradicional para las partes críticas (ejecución, manejo de errores, gestión estatal).

La revolución del agente está llegando. Simplemente no se parecerá a lo que todos prometen en 2025. Y eso es exactamente por qué tendrá éxito.

Las lecciones reales de las trincheras

La brecha entre “obras en demostración” y “trabajos a escala” es enorme, y la mayoría de la industria todavía está resolviendo esto.

Si estás trabajando en problemas similares, me encantaría continuar con esta conversación. Los desafíos en torno a la confiabilidad del agente, la optimización de costos y la complejidad de la integración son problemas de ingeniería fascinantes que aún no tienen soluciones obvias.

Regularmente aconsejo a los equipos y compañías que navegan estos desafíos exactos, desde las decisiones de arquitectura hasta evitar las dificultades que he aprendido sobre la primera mano. Ya sea que esté evaluando las decisiones de construcción frente a comprar, depurar por qué sus agentes no están trabajando en producción, o simplemente quieren implementarlas, no dude en comunicarse.

Cuantas más personas construyan sistemas reales y compartan experiencias honestas, más rápido todos descubriremos lo que realmente funciona. Puedes encontrarme en [email protected] o x si quieres sumergirte más profundamente en alguno de estos temas.