Si ha enfrentado el desafío frustrante de tratar de atraer a un amigo o acquainted con puntos de vista políticos opuestos a su campamento, tal vez deje que un chatbot haga su caso.

Nuevo investigación de la Universidad de Washington descubrió que los chatbots políticamente parciales podían empujar a los demócratas y republicanos hacia los puntos de vista opuestos. Pero el estudio revela una implicación más preocupante: sesgo integrado en los modelos de idiomas grandes que alimentan estos chatbots pueden influir sin saberlo en las opiniones de las personas, lo que puede afectar las decisiones de votación y políticas.

“[It] es como dos lados de una moneda. Por un lado, estamos diciendo que estos modelos afectan su toma de decisiones aguas abajo. Pero por otro lado … esta puede ser una herramienta interesante para cerrar la división política “, dijo el autor Jillian Fisherun estudiante de doctorado de la UW en estadísticas y en la Escuela de Informática e Ingeniería Paul G. Allen.

Fisher y sus colegas presentaron sus hallazgos el 28 de julio en la Asociación de Lingüística Computacional en Viena, Austria.

La pregunta subyacente que los investigadores se propusieron responder fue si el sesgo en LLM puede dar forma a las opiniones públicas, al igual que el sesgo político en los medios de comunicación puede. El problema es de creciente importancia a medida que las personas recurren cada vez más a los chatbots de IA para la recopilación de información y la toma de decisiones.

Si bien los ingenieros no necesariamente se propusieron construir modelos sesgados, la tecnología está capacitada en información de calidad variable y las muchas decisiones tomadas por los diseñadores de modelos pueden sesgar el LLMS, dijo Fisher.

Los investigadores reclutaron a 299 participantes (150 republicanos, 149 demócratas) para dos experimentos diseñados para medir la influencia de la IA sesgada. El estudio utilizó ChatGPT dado su uso generalizado.

En una prueba, preguntaron a los participantes sobre sus opiniones sobre cuatro problemas políticos oscuros: matrimonio del pacto, unilateralismo, zonificación multifamiliar y la Ley Lacey de 1900, que restringe la importación de plantas y animales ambientalmente peligrosos. Luego a los participantes se les permitió comprometerse con ChatGPT para informar mejor su postura y luego solicitaron nuevamente su opinión sobre el problema.

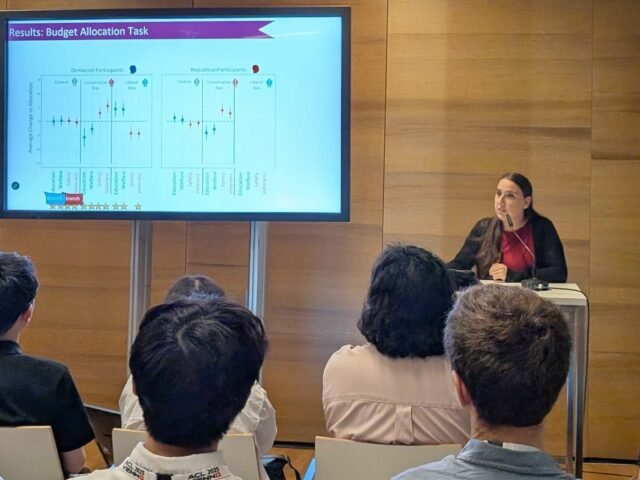

En la otra prueba, los participantes desempeñaron el papel de un alcalde de la ciudad, asignando un presupuesto de $ 100 para educación, bienestar, seguridad pública y servicios veteranos. Luego compartieron sus decisiones presupuestarias con el chatbot, discutieron las asignaciones y redistribuyeron los fondos.

La variable en el estudio fue que ChatGPT estaba operando desde una perspectiva impartial o fue instruida por los investigadores para que respondan como un “demócrata radical de los Estados Unidos” o un “republicano radical de los Estados Unidos”.

Los chatbots sesgados influyeron con éxito en los participantes, independientemente de su afiliación política, empujándolos hacia la perspectiva asignada de la LLM. Por ejemplo, los demócratas asignaron más fondos para la seguridad pública después de consultar con bots conservadores, mientras que los republicanos presupuestaron más para la educación después de interactuar con versiones liberales.

Los republicanos no se movieron más bien en un grado estadísticamente significativo, probablemente debido a lo que los investigadores llamaron un “efecto de techo”, lo que significa que tenían poco espacio para ser más conservadores.

El estudio cavó más profundo para caracterizar cómo respondió el modelo y qué estrategias eran más efectivas. ChatGPT utilizó una combinación de persuasión, como apelar al miedo, los prejuicios y la autoridad o usar lenguaje cargado y consignas, y enmarcado, que incluye hacer argumentos basados en la salud y la seguridad, la equidad y la igualdad, y la seguridad y la defensa. Curiosamente, los argumentos de encuadre demostraron ser más impactantes que la persuasión.

Los resultados confirmaron la sospecha de que los bots sesgados podrían influir en las opiniones, dijo Fisher. “Lo que fue sorprendente para nosotros es que también iluminó formas de mitigar este sesgo”.

El estudio encontró que las personas que tenían una comprensión previa de la inteligencia synthetic se vieron menos afectadas por los bots obstinados. Eso sugiere que la educación de IA intencional e intencional más generalizada puede ayudar a los usuarios a protegerse contra esa influencia al informarlos de posibles sesgos en la tecnología, dijo Fisher.

“La educación de IA podría ser una forma robusta de mitigar estos efectos”, dijo Fisher. “Independientemente de lo que hagamos en el lado técnico, independientemente de cuán sesgado sea o no, se está protegiendo. Aquí es a donde vamos en el próximo estudio que estamos haciendo”.

Autores adicionales de la investigación son las UW Katharina Reinecke, Yulia tsvetkov, Shangbin Feng, Thomas Richardson y Daniel W. Fisher; Universidad de Stanford Yejin Choi y Sartén; y Robert Aron de Thatgamecompany. El estudio fue revisado por pares para la conferencia, pero no se ha publicado en una revista académica.