En la period de los medios sintéticos, lo actual ya no es obvio. Falas profundas. Una vez que las cosas de ciencia ficción ahora son accesibles, hiperrealistas y alarmantemente fáciles de crear gracias a la IA generativa. Pero a medida que estos movies y voces falsas inundan nuestros alimentos, surge una pregunta de alto riesgo: ¿podemos luchar contra la IA con IA?

La respuesta puede definir el futuro de la confianza en línea.

Este weblog explora la vanguardia de la “detección de AI-on-AI”, donde los sistemas de aprendizaje automático están siendo entrenados no solo para imitar a los humanos, sino para burlar a sus contrapartes sintéticas. Desglosaremos cómo funcionan estos sistemas, por qué la mayoría de los detectores actuales se quedan cortos y lo que se necesitará para construir algoritmos que realmente puedan mantenerse al día con un adversario que aprende a la velocidad del cálculo.

Ya sea que sea un líder tecnológico preocupado por la información errónea, un desarrollador que construye productos de software program o simplemente alguien curioso sobre la próxima fase de la verdad digital, lo guiaremos a través de los avances, los desafíos y la cuerda ética de la IA luchando contra la IA.

Desempaquemos la carrera armamentista que no sabías que ya estaba sucediendo.

¿Qué hace que los profundos profundos sean tan difíciles de detectar?

Los defectos profundos ya no son parodias pixeladas, son pulidas, persuasivas y prácticamente indetectables para el ojo humano. Gracias a los poderosos modelos de IA generativos como Gans (redes adversas generativas) y modelos de difusión, las máquinas ahora pueden fabricar audio, video e imágenes hiperrealistas que imitan a las personas reales con precisión misteriosa. Estos modelos no solo generan imágenes, simulan microexpresiones faciales, audio de sincronización de labios a marcos de video e incluso replican el tono de voz y la cadencia.

El problema? Los métodos de detección tradicionales, como el análisis handbook o la marca de agua estática, son simplemente demasiado lentos, demasiado poco profundos o demasiado frágiles. A medida que los defensores profundos se vuelven más sofisticados, estas técnicas heredadas se desmoronan. A menudo confían en detectar artefactos a nivel de superficie (como parpadeos irregulares o iluminación antinatural), pero los modelos modernos de Deepfake están aprendiendo a borrar eso.

En resumen: estamos lidiando con un adversario que cambia de forma. Uno que aprende, se adapta y evoluciona más rápido que los sistemas basados en reglas puede mantenerse al día. Detectar DeepFakes ahora requiere modelos de IA que son tan inteligentes e idealmente, un paso por delante.

Cómo funciona la detección de Deepfake basada en AI

Si los profundos son el virus, la IA podría ser la vacuna.

La detección de Deepfake basado en AI trabaja al enseñar modelos para reconocer inconsistencias sutiles, a menudo invisibles, en los medios falsos, cosas que la mayoría de los humanos nunca notarían. Estos incluyen movimientos faciales antinaturales, inconsistencias en iluminación y reflexiones, sincronización de labios no coincidente, distorsiones a nivel de píxeles o señales de audio que no se alinean con la forma y el tiempo de la boca.

Para hacer esto, los modelos de detección están entrenados en conjuntos de datos masivos de medios reales y falsos. Con el tiempo, aprenden las “huellas digitales” del contenido sintético, los patrones en el ruido, las anomalías en la compresión o las peculiaridades estadísticas en cómo se comportan los píxeles.

Estos son los enfoques clave que alimentan esta revolución de detección:

- Redes neuronales convolucionales (CNN): Estos modelos se destacan al analizar imágenes marco por marco. Pueden retomar los artefactos de píxeles minuciosos, la mezcla de borde antinatural o texturas inconsistentes que insinúan la falsificación.

- Modelos de transformadores: Originalmente construido para el procesamiento del lenguaje pure, los transformadores ahora se utilizan para analizar secuencias temporales en video y audio. Son ideales para detectar inconsistencias con el tiempo, como una sonrisa que permanece demasiado tiempo o una voz que no está sincronizada.

- Entrenamiento adversario: Esta técnica utiliza un tipo de modelo “Ai Spy vs. AI Spy”. Una purple genera profundos, mientras que la otra aprende a detectarlos. El resultado? Un bucle de mejora continua donde los modelos de detección agudizan sus habilidades contra medios sintéticos cada vez más avanzados.

Juntos, estos métodos forman la columna vertebral de la detección moderna de Deepfake, inteligente, escalable y cada vez más esencial en la lucha por preservar la confianza digital.

High 5 herramientas para usar para la detección de Deepfake

A medida que los defectos se vuelven más convincentes, ha surgido una nueva generación de herramientas para ayudar a organizaciones, periodistas y plataformas a separar los hechos de la fabricación. Estas son cinco de las herramientas de detección de Deepfake más efectivas y ampliamente utilizadas hoy en día:

1. Autenticador de video de Microsoft

Desarrollado como parte del programa de democracia defensores de Microsoft, esta herramienta analiza movies y proporciona un puntaje de confianza que indica si los medios probablemente se manipulan. Detecta el desvanecimiento sutil o la mezcla que puede no ser seen para el ojo humano.

Lo mejor para: Integridad electoral, salas de redacción, instituciones de orientación pública.

2. Intel Fakecatcher

Fakecatcher se destaca por usar señales biológicas para detectar falsificaciones. Analiza cambios sutiles en el flujo sanguíneo en la cara de un sujeto, basado en los cambios de shade en los píxeles, para verificar la autenticidad.

Lo mejor para: Detección en tiempo actual de Deepfake y entornos de alto riesgo como la defensa o las finanzas.

3. Escáner de Deepware

Una plataforma fácil de usar que escanea archivos multimedia y marca contenido generado por IA utilizando una extensa base de datos de marcadores sintéticos conocidos. Está basado en el navegador y no requiere habilidades de codificación.

Lo mejor para: Periodistas, educadores y usuarios cotidianos verifican movies sospechosos.

4. Sensidad ai (anteriormente DeepTrace)

Sensity ofrece detección de defake profundo de grado empresarial e inteligencia de amenazas visuales. Monitorea fuentes internet oscuras, plataformas sociales y contenido de video para medios sintéticos maliciosos en tiempo actual.

Lo mejor para: Grandes empresas, aplicación de la ley y profesionales de ciberseguridad.

5. Realidad defensor

Construido para la implementación empresarial, Actuality Defender se integra en las tuberías de moderación y verificación de contenido existente. Combina múltiples modelos de detección que incluyen CNN y transformadores, para resultados de alta precisión.

Lo mejor para: Plataformas de redes sociales, redes publicitarias y protección de derechos digitales.

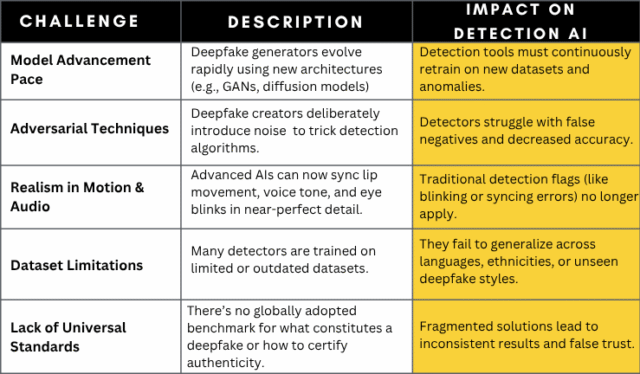

Desafíos: ¿La IA puede mantenerse al día con la IA?

Bienvenido a la carrera armamentista AI, donde el atacante y el defensor son máquinas, evolucionando en tiempo actual.

Cada vez que se capacita a un nuevo modelo de IA para detectar deffaces profundos, un modelo de generador aún más avanzado está justo detrás de él, aprendiendo a evitar esa misma defensa. Esta escalada de ida y vuelta significa que el mejor detector de hoy puede convertirse en la reliquia anticuada del mañana. Es un juego constante de ponerse al día, impulsado por dos fuerzas competidoras:

AI generativa: Con el objetivo de hacer que el contenido sintético sea indistinguible de la realidad.

Detección AI: Esforzándose por encontrar las huellas digitales que revelan la manipulación.

Así es como se desarrolla esta batalla creciente:

Implicaciones empresariales: confianza en la period de los medios sintéticos

Deepfakes no son solo un problema del consumidor, son una disaster corporativa que espera que suceda. En una period en la que el video puede mentir y el audio puede engañar, las empresas en todas las industrias deben defender de manera proactiva la confianza, la reputación y la seguridad. Así es como Deepfake Detection se está convirtiendo en la misión crítica para los sectores clave:

Medios y periodismo: protección de credibilidad

Las entrevistas falsas, los clips de prensa sintéticos y los anclajes sonerados pueden difundir la información errónea más rápido de lo que la verdad puede ponerse al día. Las organizaciones de medios deben adoptar la detección de defectos profundos para validar las fuentes, proteger la confianza pública y evitar convertirse en amplificadores no sabios de desinformación generada por IA.

Authorized y cumplimiento: preservar la integridad de la evidencia

Un video o un clip de audio profundo puede alterar el resultado de los procedimientos legales. En ley, donde las deposiciones de video, las imágenes de vigilancia y el testimonio grabado son críticos, la detección de defake profundo es esencial para verificar la evidencia digital y mantener la cadena de confianza.

Ciberseguridad: detener los ataques de suplantación

Las estafas de phishing y suplantación de voz de Deepfake ya se dirigen a ejecutivos en ataques de ingeniería social. Sin la detección en tiempo actual, las empresas corren el riesgo de la pérdida financiera, las violaciones de datos y el sabotaje interno. Los equipos de ciberseguridad ahora deben tratar los medios sintéticos como un vector de amenaza de primer nivel.

Recursos humanos: prevención de candidatos fraudulentos

Se reanuda el video falso y las entrevistas generadas por IA pueden permitir a los malos actores pasar el proceso de contratación. Los departamentos de recursos humanos necesitan herramientas de detección para verificar la autenticidad de las presentaciones de candidatos y proteger la integridad del lugar de trabajo.

Model & PR: Protección de la reputación corporativa

Una sola falla viral de un CEO que hace declaraciones falsas o de un escándalo de marca falso puede dañar años de equidad de marca. Las empresas necesitan sistemas de escaneo y detección proactivos para atrapar contenido falso antes de que se haga público e interrumpe la confianza de las partes interesadas.

Qué sigue: explicable AI, blockchain y detección multimodal

El futuro de la detección de Deepfake no será ganado por un solo algoritmo, será moldeado por los ecosistemas que combinan la transparencia, la trazabilidad y la inteligencia de la señal múltiple. A medida que evolucionan los profundos, también lo deben las herramientas que usamos para luchar contra ellos. Esto es lo que sigue en la carrera para burlar el engaño sintético:

AI explicable: hacer que la detección sea transparente

La mayoría de los modelos de IA funcionan como cajas negras, obtienes una salida, pero no hay concept de cómo se alcanzó. Eso no es lo suficientemente bueno para entornos de alto riesgo como la ley, los medios o el gobierno.

Explicable AI (XAI) ofrece claridad al mostrar por qué una pieza de contenido fue marcada como falsa, identificando anomalías en patrones de píxeles, características faciales inconsistentes o sincronización de labios no coincidente. Esta transparencia no solo genera confianza del usuario, sino que también ayuda en forense y validación authorized.

Blockchain: verificación de la autenticidad de los medios en la fuente

¿Qué pasa si cada foto o video vino con un sello de origen verificable?

La tecnología blockchain está emergiendo como una solución para autenticar los medios digitales en la creación. Al integrar las marcas de tiempo, los metadatos del dispositivo y las firmas criptográficas en la cadena, las empresas pueden verificar si el contenido ha sido manipulado o sigue siendo authentic, no se requiere trabajo de detectives. Proyectos como Content material Authenticity Initiative (CAI) y Challenge Origin ya están probando este enfoque.

Detección multimodal: combinación de señales visuales, de audio y de texto

Las mejores herramientas de detección de hoy no solo miran, también escuchan y leen.

La IA multimodal analiza los datos de video, voz y texto para detectar inconsistencias. Por ejemplo, puede verificar si el movimiento de los labios coincide con el audio, si el tono hablado se ajusta a la escena, o si los sonidos de fondo se agregaron artificialmente. Este enfoque holístico mejora dramáticamente la precisión en la identificación de los profundos, especialmente en medios complejos o de alta resolución.

Envolviendo: luchar contra los deffaces con IA más inteligente, construido éticamente

A medida que los medios sintéticos se vuelven indistinguibles de la realidad, la pregunta no es si su organización enfrentará una amenaza de defake, es cuándo. ¿La única forma de mantenerse a la vanguardia? Invierta en IA que no solo sea reactivo, sino que sea resistente, explicable y seguro.

En Ishir, nos especializamos en la construcción de sistemas de IA de grado empresarial que puedan detectar, marcar y aprender de las amenazas en evolución como Deepfakes. Ya sea que esté en medios, leyes, recursos humanos o ciberseguridad, lo ayudamos:

- Implementar modelos de detección de IA personalizados capacitados en datos de amenazas del mundo actual

- Integrar marcos de detección multimodal para la verificación de voz, video y texto

- Use la IA explicable para garantizar la transparencia, la trazabilidad y la auditorabilidad

- Aplicar protocolos de autenticidad basados en blockchain para salvaguardar los activos digitales

Nuestras soluciones no son de talla única, están diseñadas especialmente para hacer que su negocio sea irrompible frente al engaño digital.

¿Está su organización lista para confiar en lo que ve, escucha y comparte?

Construya su pila de defensa de Deepfake con la experiencia de IA de Ishir.

¿La publicación puede ser entrenada para detectar defensores profundos hechos por otras IA? apareció primero en Ishir | Desarrollo de software program India.