Tabla de enlaces

Resumen y 1. Introducción

-

Trabajo relacionado

2.1 Texto a la generación vocal

2.2 Generación de texto a movimiento

2.3 Generación de audio a movimiento

-

Conjunto de datos de estrago

3.1 subconjunto de rap-vocal

3.2 subconjunto de movimiento de rap

-

Método

4.1 Formulación de problemas

4.2 MOVIMIENTO TOKENIZER VQ-VAE

4.3 tokenizador de audio vocal2unit

4.4 Modelado basic de autosuficiencia

-

Experimentos

5.1 Configuración experimental

5.2 Análisis de resultados principales y estudio de ablación 5.3

-

Conclusión y referencias

A. Apéndice

Un apéndice

El materials suplementario se organiza de la siguiente manera: Sec. A.1 proporciona una demostración del sitio net para mostrar resultados cualitativos adicionales; Segundo. A.2 presenta detalles adicionales de las arquitecturas de crimson; Segundo. A.3 introduce métricas de evaluación; Segundo. A.4 presenta estudios de ablación adicionales; Segundo. A.5 muestra resultados cualitativos adicionales; Segundo. A.6 discute impactos sociales más amplios del trabajo.

A.1 Demo del sitio net

Para proporcionar resultados cualitativos más vívidos y claros, hacemos una demostración de un sitio net suplementario para demostrar la calidad de generación de nuestro sistema propuesto. Alentamos a los lectores a ver los resultados en

A.2 Detalles de implementación

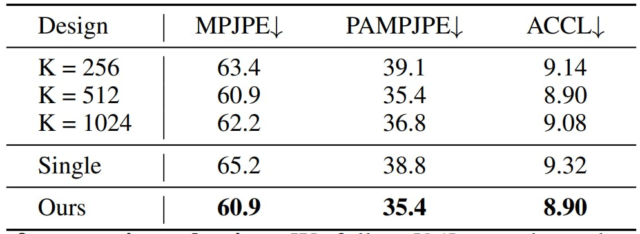

Tokenizer de movimiento. Entrenamos tres autoencoders de variacionales cuantificados vectoriales (VQ-VAE) para la cara, el cuerpo y la mano, respectivamente. Adoptamos la misma arquitectura VQ-VAE basada en [14, 69, 23]. Para las funciones de pérdida que optimizan los tokenizadores de movimiento, utilizamos la pérdida de reconstrucción suave L1, la pérdida de incrustación y la pérdida de compromiso. El peso de pérdida de compromiso se establece en 0.02. En línea con [14, 23]estrategias como la promedio móvil exponencial y la técnica de reinicio del libro de códigos [49] se implementan para optimizar la eficacia del libro de códigos durante todo el proceso de capacitación. Tomamos 512 para el tamaño del libro de códigos y establecemos la dimensión de cada código en 512. Establecimos la tasa de muestreo hacia abajo temporal en 4. Entrenamos los VQ-Vaes con un tamaño de lote de 256 y una longitud de la ventana de secuencia de 72. Adocamos a Adam con β1 = 0.9, β2 = 0.99, y una tasa de aprendizaje de 0.0002 como optimizador.

Tokenizer vocal. Para el codificador semántico, adoptamos un transformador base 12 de Hubert [20] Pretrado en el corpus Librispeech de 969 horas [41]. Siguiente [27, 45]derivamos las activaciones de características de su sexta capa. Este proceso permite que el modelo Hubert transforme el audio de entrada en un espacio vectorial de 768 dimensiones. Posteriormente, empleamos el algoritmo Ok-Means con 500 centroides para obtener códigos de contenido discretos cuantificados. Para el codificador F0, se utiliza un marco VQ-VAE para discretizar la señal F0 en tokens F0 cuantificados. Adoptamos las actualizaciones exponenciales de promedio móvil durante el entrenamiento que los VQ-VAE siguieron [6, 45]. Establecimos el tamaño del libro de códigos de VQ-VAE en 20 entradas. Además, a medida que el trabajo authentic normaliza directamente los valores de F0 extraídos para cada cantante, respectivamente, no utilizamos explícitamente las estadísticas del cantante, sino que adoptamos una capa convolucional con ventana con la entrada de audio (cortado en el tamaño de la ventana) y la incrustación del cantante como entrada. Finalmente, adoptamos una arquitectura comparable a la [17] para el codificador cantante.

Modelo basic de auto-cresivo. El modelo auto-cresivo consiste en un embedido T5 y un modelo de base. Utilizamos un codificador de larga duración como nuestro incrustador, con 24 capas y 16 cabezas. El incrustador se congela durante la capacitación en el modelo de base. El modelo de base se basa en la arquitectura del transformador de decodificador, que tiene 12 capas y 8 cabezas. Usamos Adam Optimizer con β1 = 0.9, β2 = 0.99 y una tasa de aprendizaje de 0.0002. No usamos abandono en nuestro entrenamiento. Nuestro tamaño de lote de entrenamiento es 384 para 100 épocas

A.3 Métricas de evaluación

Para evaluar la calidad de la generación de movimiento, utilizamos las siguientes métricas:

-

Distancia de inicio frechet (FID): Esta métrica mide la discrepancia de distribución entre la verdad terrestre y los movimientos generales de los gestos del cuerpo y las manos. Específicamente, entrenamos un autoencoder basado en [14] como el extractor de características de movimiento.

-

Diversidad (div): DIV evalúa la diversidad de los movimientos generados, donde calculamos la varianza a partir de las características de movimiento extraído.

-

Vértice MSE: Siguiente [66]Calculamos el error medio L2 de los vértices de labios entre los movimientos de la cara generados y la verdad del suelo.

-

Diferencia de velocidad de referencia (LVD): Introducido por [68]LVD calcula la diferencia de velocidad de los puntos de referencia faciales generados y la verdad del suelo.

-

Batir constancia (BC) [29]: BC evalúa la sincronía de los movimientos generados y las voces de canto calculando la similitud entre el ritmo de los gestos y el ritmo de audio. Específicamente, extraemos ritmos de audio usando Librosa [36]y calculamos los latidos cinemáticos como los mínimos locales de la velocidad de las articulaciones. Luego, el puntaje de alineación se deriva de la proximidad media de los ritmos de movimiento al ritmo de audio más cercano.

Para la evaluación de la calidad de la generación vocal de canto, se emplea la puntuación de opinión media (MOS). Refleja la naturalidad percibida de los tonos vocales sintetizados, con evaluadores humanos que califican cada muestra en una escala de 1 a 5, ofreciendo así una medida subjetiva de fidelidad de síntesis vocal.

A.4 Estudios de ablación adicionales

Ablación en el tokenizador de movimiento. Estudiamos diferentes diseños de nuestro tokenizador de movimiento comparando los resultados de la reconstrucción. Específicamente, exploramos VQ-VAE con diferentes tamaños de libros de códigos y estudiamos el efecto de usar un solo VQ-VAE para modelar movimientos de cuerpo completo en lugar de múltiples VQ-VA para diferentes partes del cuerpo. Como se demuestra en la tabla. 4, encontramos que usar VQ-VAE separados para la cara, el cuerpo y las manos tiene un error de reconstrucción más bajo. Y seleccionamos un tamaño de libro de códigos de 512 para nuestro modelo ultimate.

Ablación en tokenizador vocal. También estudiamos diferentes diseños para nuestro tokenizador de audio comparando los resultados de la reconstrucción. Específicamente, exploramos diferentes tamaños de libros de códigos para el codificador semántico cambiando el número Ok-Means. También comparamos el efecto con nuestro cantante incrustado en el valor posterior al valor F0. Utilizamos las siguientes métricas para medir la calidad de reconstrucción del tokenizador vocal:

-

Tasa de error de carácter (CER): Usamos Whisper [46] Para transcribir la verdad del suelo y los audios sintetizados, y luego tomar las letras de la verdad terrestre correspondiente como referencia para calcular el CER de los audios sintetizados.

-

Error de tono bruto (GPE): El porcentaje de estimaciones de tono que tienen una desviación de más del 20% en torno al verdadero tono. Solo se consideran los marcos considerados lanzados tanto por la verdad del suelo como por el audio sintetizado.

-

Error de decisión de expresión (VDE) [38]: La parte de los marcos con error de decisión de voz, es decir, los resultados que utilizan la verdad del suelo y el audio sintetizado para determinar si el marco se expresa son diferentes.

El análisis de los resultados indica que incluso el audio authentic exhibe un alto CER, que podría atribuirse a la rápida tasa de voz asociada con el rap. En algunos casos, la letra puede no ser claramente reconocible incluso por los oyentes humanos. Al comparar diferentes tamaños de libros de códigos, se observa que logran valores de GPE comparables. Se espera esta similitud en GPE ya que el mismo modelo F0 se emplea en todos los tamaños de los libros de códigos. El CER, que sirve como una medida directa de la información semántica conservada en el código, sugiere que los libros de códigos más grandes tienden a retener más información semántica. Sin embargo, la diferencia en CER entre los tamaños de los libros de códigos de Ok = 500 y Ok = 2000 es mínima. Dado que Ok = 500 demuestra mejores GPE y VDE, seleccionamos Ok = 500.

Además, ablamos un diseño sin que el cantante incruste en el preprocesamiento de F0, en su lugar, normalizando los valores de F0 para cada cantante. Muestra que este enfoque resultó en un rendimiento significativamente inferior, particularmente en la predicción de tono, en comparación con la versión modificada que incluye la incrustación del cantante.

A.5 Resultados cualitativos adicionales

Mostramos resultados cualitativos adicionales en la Fig. 4. Nuestro modelo genera hábilmente movimientos integrales de todo el mundo que encarnan la esencia de las letras de entrada. Estos incluyen movimientos de gestos auténticos que resuenan con el ritmo de la canción y los movimientos de labios sincronizados que articulan las letras.

A.6 Impactos más amplios

Esta investigación contribuye a los avances en la generación de voces sincronizadas y movimiento humano a partir de letras textuales, con el objetivo de mejorar la capacidad de los agentes virtuales para proporcionar inmersivo e interactivo

Experiencias en medios digitales. El potencial impacto positivo de este trabajo radica en su capacidad para crear actuaciones virtuales más realistas y atractivas, como en conciertos virtuales y juegos, donde los personajes pueden realizar y reaccionar de manera profundamente resonante con las expresiones humanas. Esto podría mejorar significativamente la participación del usuario en la configuración de la realidad digital y proporcionar soluciones innovadoras en las industrias de entretenimiento.

Sin embargo, esta capacidad conlleva riesgos inherentes de mal uso. La capacidad de la tecnología para generar acciones realistas como humanas y voces de canto a partir de meros textos plantea preocupaciones sobre su potencial para crear contenido engañoso o engañoso. Por ejemplo, esto podría explotarse para producir movies falsos o defensores donde los individuos parecen cantar y realizar que nunca ocurrieron, lo que podría usarse para difundir la información errónea o perjudicar la reputación. Reconociendo estos riesgos, es essential abogar por pautas éticas y marcos robustos para garantizar el uso responsable de tales tecnologías.

Autores:

(1) Jiaben Chen, Universidad de Massachusetts Amherst;

(2) Xin Yan, Universidad de Wuhan;

(3) Yihang Chen, Universidad de Wuhan;

(4) Siyuan Cen, Universidad de Massachusetts Amherst;

(5) Qinwei MA, Universidad de Tsinghua;

(6) Haoyu Zhen, Universidad de Shanghai Jiao Tong;

(7) Kaizhi Qian, MIT-IBM Watson AI Lab;

(8) mentir Lu, Dolby Laboratories;

(9) Chuang Gan, Universidad de Massachusetts Amherst.

![Tabla 4: Evaluación de nuestro tokenizador de movimiento. Seguimos [34] para evaluar los errores de reconstrucción de movimiento de nuestro movimiento VQVAE Modelo VM. MPJPE y PAMPJPE se miden en milímetros. ACCL indica un error de aceleración.](https://hackernoon.imgix.net/images/hYnD3aGcZIgKnjRGl8QfkZDGyBF2-yi832yj.png?auto=format&fit=max&w=2048)

![Tabla 5: Evaluación de nuestro modelo Unit2Wav. Seguimos [45] para evaluar los errores de resíntesis del habla de nuestro modelo Unit2Wav. Wer, GPE y VDE, expresados como porcentajes, indican la tasa de error del carácter, el error de gran tono y el error de decisión de voz.](https://hackernoon.imgix.net/images/hYnD3aGcZIgKnjRGl8QfkZDGyBF2-jc9325k.png?auto=format&fit=max&w=3840)